Тест Тьюринга / Хабр

Итак сегодня мы поговорим о самом известном тесте для оценки говорящего бота — это тест Тьюринга.

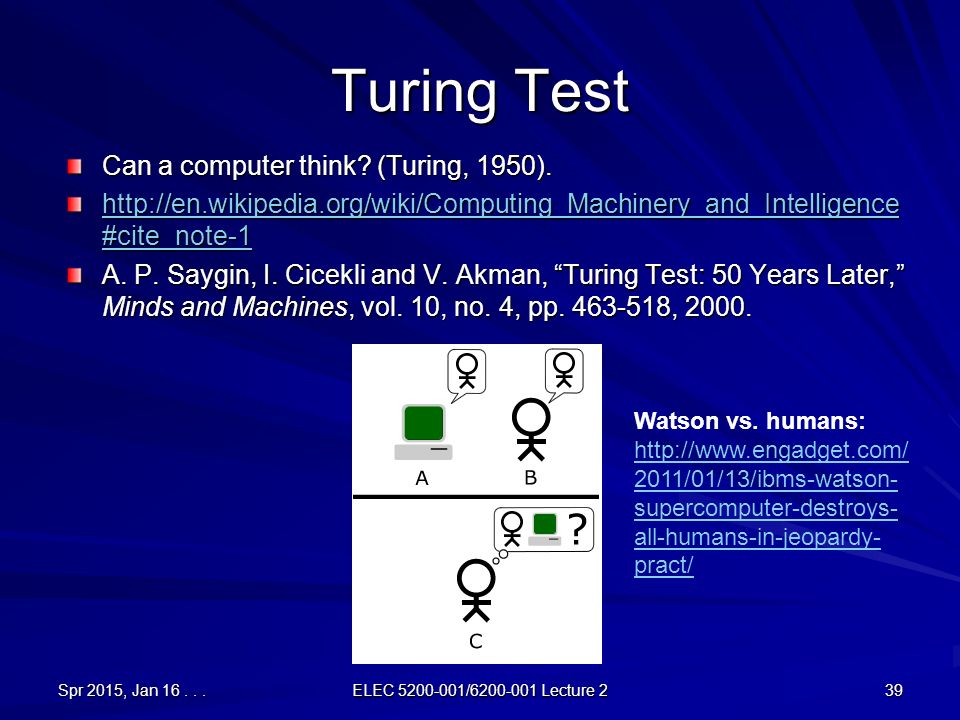

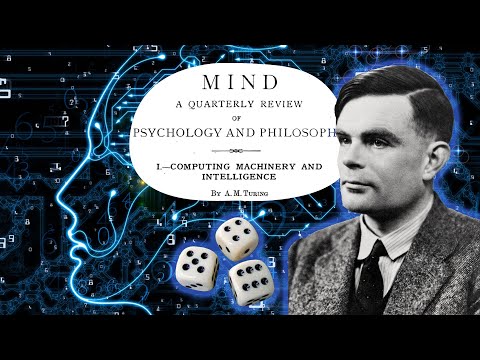

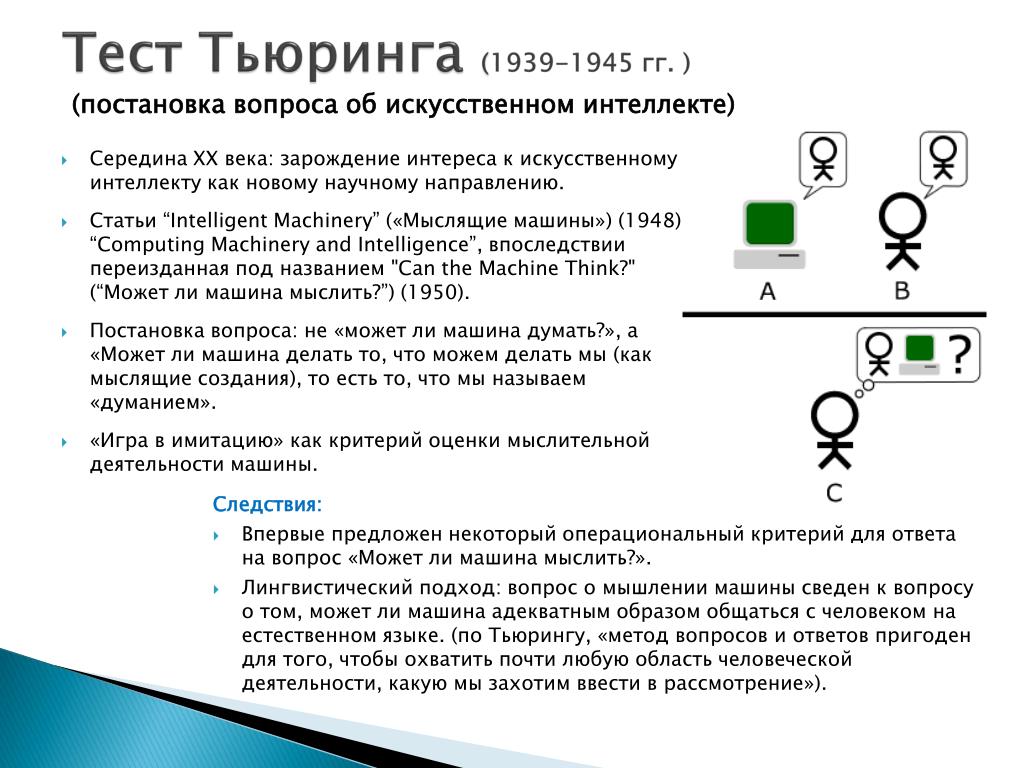

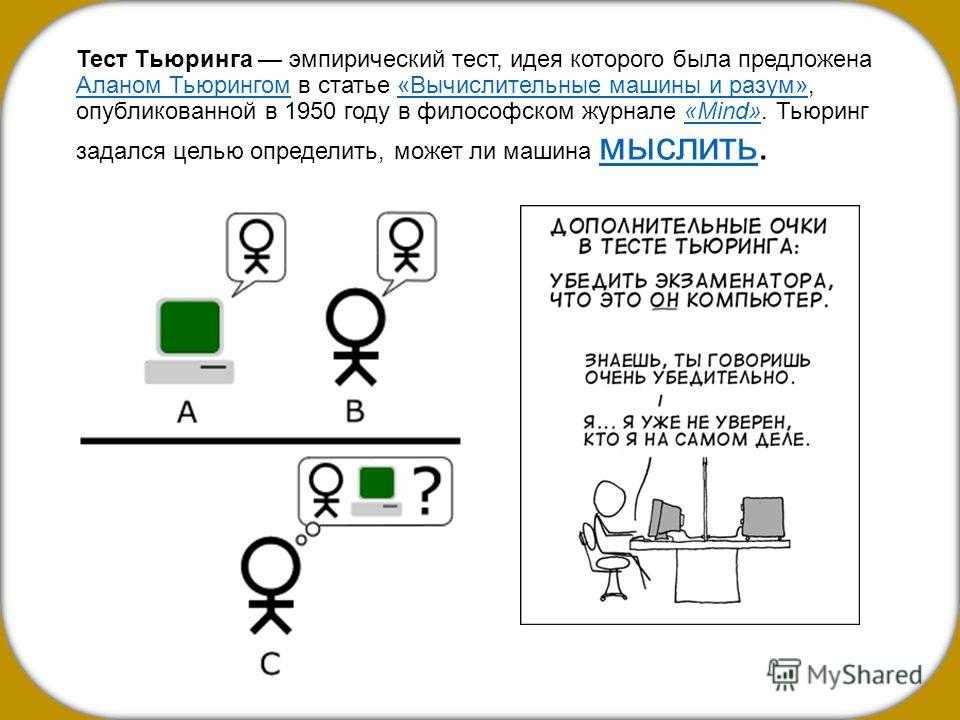

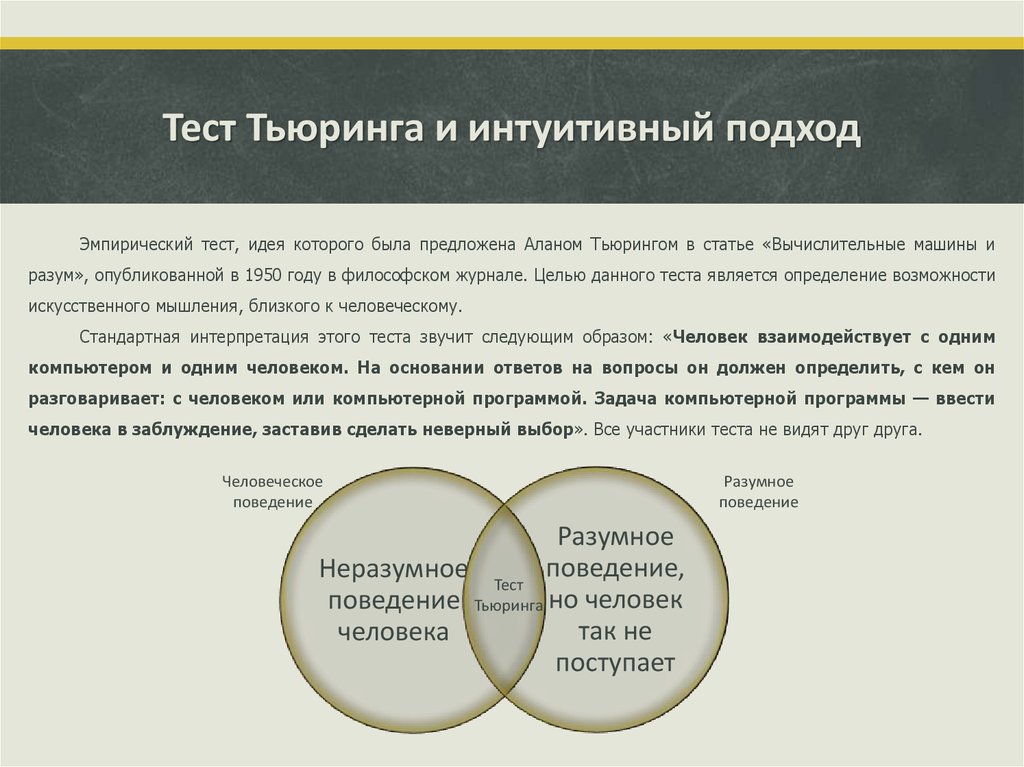

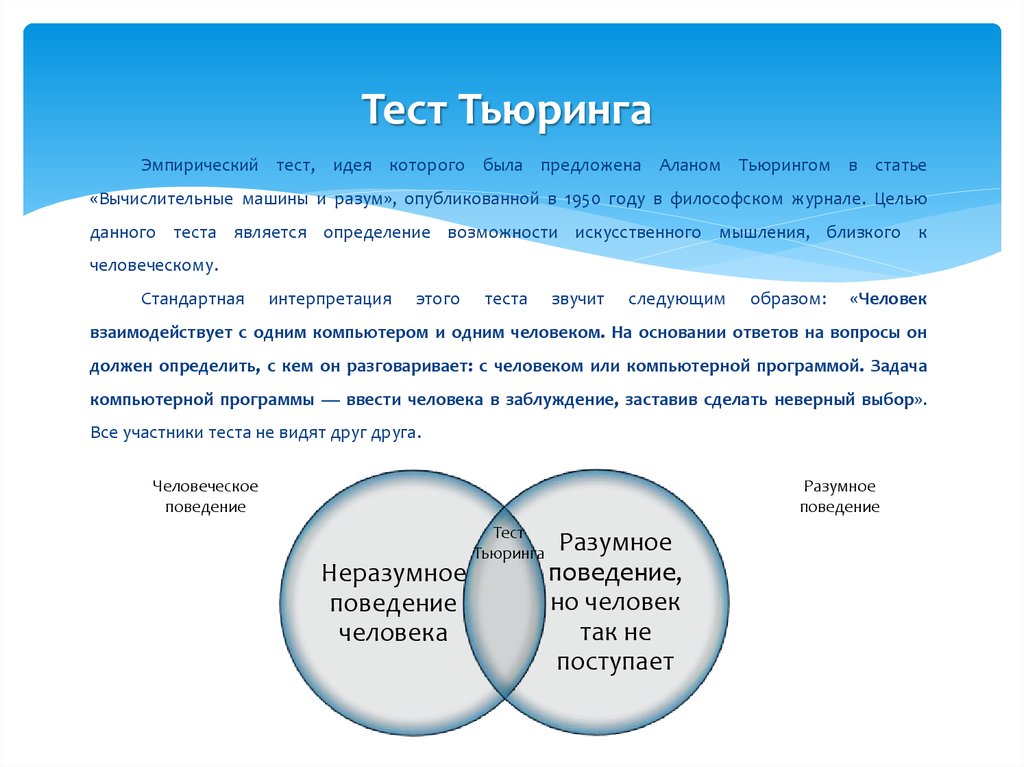

Тест Тьюринга — эмпирический тест, идея которого была предложена Аланом Тьюрингом в статье «Вычислительные машины и разум» (англ. Computing Machinery and Intelligence), опубликованной в 1950 году в философском журнале «Mind». Тьюринг задался целью определить, может ли машина мыслить.

Стандартное звучание закона: «Если компьютер может работать так, что человек не в состоянии определить, с кем он общается — с другим человеком или с машиной, — считается, что он прошел тест Тьюринга»

Разумные, подобные человеку машины на протяжении многих десятилетий были одной из основных тем научно-фантастических произведений. С момента зарождения современной вычислительной техники умы людей занимал вопрос: можно ли построить машину, которая могла бы в чем-то заменить человека. Попыткой создать твердую эмпирическую почву для решения этого вопроса и стал тест, разработанный Аланом Тьюрингом.

Первый вариант теста, опубликованный в 1950 году, был несколько запутанным. Современная версия теста Тьюринга представляет собой следующее задание. Группа экспертов общается с неизвестным существом. Они не видят своего собеседника и могут общаться с ним только через какую-то изолирующую систему — например, клавиатуру. Им разрешается задавать собеседнику любые вопросы, вести разговор на любые темы. Если в конце эксперимента они не смогут сказать, общались ли они с человеком или с машиной, и если на самом деле они разговаривали с машиной, можно считать, что эта машина прошла тест Тьюринга.

Существуют, по крайней мере, три основных варианта теста Тьюринга, два из которых были предложны в статье «Вычислительные машины и разум», а третий вариант, по терминологии Саула Трейджера (Saul Traiger), является стандартной интерпретацией.

Наряду с тем, что существует определенная дискуссия, соответствует ли современная интерпретация тому, что описывал Тьюринг, либо она является результатом неверного толкования его работ, все три версии не считаются равносильными, их сильные и слабые стороны различаются.

Имитационная игра

Тьюринг, как мы уже знаем, описал простую игру для вечеринок, которая включает в себя минимум трех игроков. Игрок А — мужчина, игрок В — женщина и игрок С, который играет в качестве ведущего беседу, любого пола. По правилам игры С не видит ни А, ни В и может общаться с ними только посредством письменных сообщений. Задавая вопросы игрокам А и В, С пытается определить, кто из них — мужчина, а кто — женщина. Задачей игрока А является запутать игрока С, чтобы он сделал неправильный вывод. В то же время задачей игрока В является помочь игроку С вынести верное суждение.

В той версии, которую С. Г. Стеррет (S. G. Sterret) называет «Первоначальный тест на основе имитационной игры» (Original Imitation Game Test), Тьюринг предлагает, чтобы роль игрока А исполнял компьютер. Таким образом, задачей компьютера является притвориться женщиной, чтобы сбить с толку игрока С. Успешность выполнения подобной задачи оценивается на основе сравнения исходов игры, когда игрок А — компьютер, и исходов, когда игрок А — мужчина.

Второй вариант предложен Тьюрингом в той же статье. Как и в «Первоначальном тесте», роль игрока А исполняет компьютер. Различие заключается в том, что роль игрока В может исполнять как мужчина, так и женщина.

«Давайте рассмотрим конкретный компьютер. Верно ли то, что модифицируя этот компьютер с целью иметь достаточно места для хранения данных, увеличивая скорость его работы и задавая ему подходящую программу, можно сконструировать такой компьютер, чтобы он удовлетворительно выполнял роль игрока А в имитационной игре, в то время как роль игрока В выполняет мужчина?», — Тьюринг, 1950, стр. 442.

В этом варианте оба игрока А и В пытаются склонить ведущего к неверному решению.

Главной мыслью данной версии является то, что целью теста Тьюринга является ответ не на вопрос, может ли машина одурачить ведущего, а на вопрос, может ли машина имитировать человека или нет. Несмотря на то, что идут споры о том, подразумевался ли этот вариант Тьюрингом или нет, Стеррет считает, что этот вариант Тьюрингом подразумевался и, таким образом, совмещает второй вариант с третьим. В это же время группа оппонентов, включая Трейджера, так не считает. Но это все равно привело к тому, что можно назвать «стандартной интерпретацией». В этом варианте игрок А — компьютер, игрок В — человек любого пола. Задачей ведущего является теперь не определить кто из них мужчина и женщина, а кто из них компьютер, а кто — человек.

Несмотря на то, что идут споры о том, подразумевался ли этот вариант Тьюрингом или нет, Стеррет считает, что этот вариант Тьюрингом подразумевался и, таким образом, совмещает второй вариант с третьим. В это же время группа оппонентов, включая Трейджера, так не считает. Но это все равно привело к тому, что можно назвать «стандартной интерпретацией». В этом варианте игрок А — компьютер, игрок В — человек любого пола. Задачей ведущего является теперь не определить кто из них мужчина и женщина, а кто из них компьютер, а кто — человек.

Тьюринг в 2012

Для организации мероприятий по празднованию в 2012 году столетия со дня рождения Тьюринга создан специальный комитет, задачей которого является донести мысль Тьюринга о разумной машине, отраженную в таких голливудских фильмах, как «Бегущий по лезвию», до широкой публики, включая детей. В работе комитета участвуют: Кевин Ворвик, председатель, Хьюма Ша, координатор, Ян Бланд (Ian Bland), Крис Чапмэн (Chris Chapman), Марк Аллен (Marc Allen), Рори Данлоуп (Rory Dunlop), победители конкурса на получение премии Лёбнера Робби Гарне и Фред Робертс (Fred Roberts).

Минимальный тест Тьюринга: докажи одним словом, что ты — человек

- Дэвид Робсон

- BBC Future

Подпишитесь на нашу рассылку ”Контекст”: она поможет вам разобраться в событиях.

Автор фото, Getty Images

По мере того как компьютеры становятся все умнее, способы провести грань между нами и разумными машинами становятся все изощреннее. Но есть как минимум одно волшебное слово…

Представьте себе, что вы и робот, оснащенный искусственным интеллектом, предстали перед неким судьей, который вас обоих не видит, а только слышит.

Этот судья должен вынести решение, кто из вас человек — и значит останется жить, а второй — умрет.

И вы, и разумный робот — вы оба хотите остаться в живых. Судья умен и справедлив. И он говорит: «Вы должны мне сказать всего одно слово. На основании этого слова я решу, кто из вас человек».

Судья умен и справедлив. И он говорит: «Вы должны мне сказать всего одно слово. На основании этого слова я решу, кто из вас человек».

Какое слово вы бы выбрали?

Что-нибудь из возвышенных духовных концепций — например, «душа»? Или нечто отражающее ваши вкусы («музыка»)? Или чисто телесную функциональную особенность («пукнуть»)?

Этот незамысловатый эксперимент может показаться надуманной забавой, но некоторые ученые, занимающиеся проблемами познания, считают, что он может выявить наши основные представления об искусственном интеллекте и в то же самое время позволит открыть некоторые удивительные вещи о том, как работает наш разум.

- Три угрозы человечеству, которые несет искусственный интеллект

- Не бойтесь искусственного разума, он нас спасет

- Искусственный интеллект — угроза или помощник для человечества?

- Каким не должно быть общество будущего — девять советов

В конце концов, автоматизированные боты в чатах и прочая генерирующая речь аппаратура все больше и больше задействуют искусственный разум, чтобы поддерживать разговор с нами, людьми, или писать тексты, с которыми мы сталкиваемся ежедневно в интернете.

Можем ли мы наверняка сказать, что сотрудник клиентской службы, с которым мы обмениваемся сообщениями онлайн, — реальная личность? Или это всего лишь болтливый алгоритм?

Сможем ли мы отличить историю, придуманную машиной, от написанной настоящим писателем, потратившим на нее творческие силы и вдохновение?

Коммуникативный искусственный интеллект — уже давно не теория, и нам надо быть готовыми к общению с ним.

Автор фото, Getty Images

Подпись к фото,Сейчас легко отличить роботов от людей, но по мере того как компьютеры будут становиться все умнее, нам придется научиться четко распознавать, кто есть кто — человек ли по ту сторону экрана или машина

Джон Маккой, один из исследователей Массачусетского технологического института, говорит, что однажды его вдохновил на эксперимент простой разговор с коллегами.

Они обсуждали так называемый тест Тьюринга, впервые разработанный британским ученым Аланом Тьюрингом в 1950 г. и направленный на то, чтобы определить, насколько поведение компьютера отлично (или неотличимо) от человеческого.

и направленный на то, чтобы определить, насколько поведение компьютера отлично (или неотличимо) от человеческого.

(Участники этого теста не видят друг друга, и если судья не может точно сказать, кто из собеседников человек, то считается, что машина прошла тест. Беседа ведется в режиме «только текст», например, с помощью клавиатуры и экрана компьютера-посредника. — Ред.)

- Искусственный интеллект взял еще один рубеж. Теперь он может спорить с человеком

- Девять алгоритмов, которые уже принимают за вас решения

«Нам показалось интересным установить, что может стать минимальной версией теста Тьюринга», — объясняет Маккой.

И в конце концов они свели весь тест к единственному слову.

«И тогда возник вопрос: какие слова выбрали бы люди?» Вопрос этот в итоге вдохновил ученых на целое исследование, результаты которого опубликованы в этом году в «Журнале экспериментальной социальной психологии» (Journal of Experimental Social Psychology).

В первом из экспериментов Маккой с коллегой Томером Аллманом задали более чем тысяче участников упомянутый выше вопрос и затем проанализировали полученные таким образом слова, попытавшись найти какие-то общие тенденции.

Вот какими были 10 наиболее часто названных слов (по степени их популярности):

- Любовь (134 человека)

- Сострадание (33)

- Человеческий (30)

- Пожалуйста (25)

- Милосердие (18)

- Сопереживание (17)

- Эмоция (14)

- Робот (13)

- Человечество (11)

- Живой (9)

Автор фото, Getty Images

Подпись к фото,Юмор, сарказм и слова, относящиеся к функциям организма, были расценены как нечто, позволяющее опознать человека

Пропустить Подкаст и продолжить чтение.

Подкаст

Что это было?

Мы быстро, просто и понятно объясняем, что случилось, почему это важно и что будет дальше.

эпизоды

Конец истории Подкаст

«Поразительно, насколько много у людей совпало, — говорит Маккой, который сейчас работает в Пенсильванском университете. — Они могли выбрать любое слово из стандартного английского языка и все-таки выбрали то же, что и многие другие».

Возьмите хотя бы слово «любовь» — его выбрали около 10%. Всего же четверть всех участников выбрала хотя бы одно из первых четырех слов приведенного списка.

Самыми популярными категориями были слова, относящиеся к телесным функциям (например, «какашка»), к вере и прощению («надежда», «милосердие»), к эмоциям («сопереживание») и к пище («бананы»).

Затем Маккой и Аллман провели второй эксперимент, чтобы выяснить, как другие люди реагируют на слова, полученные при помощи первого эксперимента.

Действительно ли самые популярные ответы наиболее успешно передают «человечность», как считали участники первого этапа исследования? И если это так, то какие слова делают это наилучшим образом?

Автор фото, Getty Images

Подпись к фото,Любовь — это концепция, которую компьютеру крайне трудно понять

Итак, исследователи объединили полученные ими слова в пары (например, «человеческий» и «любовь») и предложили второй группе участников определить, какое из этих двух наиболее вероятно выбрано человеком, а какое — компьютером.

Как мы уже увидели в первом эксперименте, «любовь» была одним из самых популярных слов.

Однако участники второго этапа сочли самым эффективным слово «какашка».

Конечно, может показаться удивительным, что экскременты стали секретным паролем человечества, но такие результаты свидетельствуют: осознанно нарушая табу и провоцируя, а не просто описывая некую эмоцию, вы наиболее прямо сообщаете, что вы — человек. И тут можно зайти далеко, не останавливаясь на невинной какашке.

И тут можно зайти далеко, не останавливаясь на невинной какашке.

Некоторые другие «чисто человеческие» слова также вызывали эмоциональную реакцию — значительно более сильную, чем предполагает их толкование словарем. Например, «пожалуйста» или «влажный».

Еще были слова, которые просто приятно произносить. Попробуйте сказать «ономатопея» несколько раз подряд. Здорово, правда?

- Больше, чем робот: секс-кукла, с которой можно и поговорить

- Ведущий с искусственным интеллектом: а вы отличите настоящего?

Говоря в общем, такой выбор «человеческих» слов справедливо отражает нынешнее состояние искусственного интеллекта.

Хотя боты могут составлять простые описательные предложения и даже вполне связные короткие тексты, им по-прежнему недоступны юмор и сарказм.

Ведь юмор требует глубокого понимания контекста, культурных ассоциаций, заложенных практически в каждое слово.

Автор фото, Getty Images

Подпись к фото,Некоторые слова (такие, как «влажный») рождают глубокую эмоциональную реакцию, никак не отраженную определением в словаре

Но пойдем дальше этих причудливых рассуждений. Как представляется Маккою, этот эксперимент может стать полезным инструментом для понимания того, что люди могут думать о других группах людей.

Например, какое слово вы бы выбрали, чтобы показать, что вы — женщина? Или что вы — француз? Или социалист?

В каждом из случаев ваш выбор отразит те качества, которые, как мы считаем, свойственны той или иной группе людей и которые члены этой группы примут в качестве своих. А для тех, кто не принадлежит к данной группе, эти качества покажутся чуждыми, непонятными или недостойными упоминания.

- Боты изобрели свой язык: почему Facebook испугался искусственного интеллекта?

- За пределом понимания: можно ли доверять искусственному интеллекту?

- Хокинг: искусственный интеллект — угроза человечеству

Между тем, Маккой обнаружил, что его «Минимальный тест Тьюринга» полезен для провоцирования дальнейшего обсуждения сущности искусственного интеллекта.

«Было забавно задавать такой вопрос видным психологам: они крепко-крепко задумывались над тем, какое слово выбрать, а позже, спустя несколько часов, в возбуждении прибегали ко мне, чтобы изменить свой ответ», — рассказывает Маккой.

«Этот очень простой вопрос заставляет вас глубоко задуматься об отличии человеческого разума от компьютерного и о том, как эти два разума взаимодействуют».

Его собственный любимый ответ обманчиво прост. «Одно из тех слов, которые мне понравились больше всего, — это «м-м-м…» — по-моему, очень умный выбор», — говорит Маккой.

В общем, полезно запомнить: если в нашем мире, все больше зависящем от компьютеров, вы однажды окажетесь в ситуации, когда необходимо будет доказать, что вы человек, — шутите. Или выбирайте слова, которые не принято произносить в приличном обществе.

—

Прочитать оригинал этой статьи на английском языке можно на сайте BBC Future.

404: Страница не найдена

Страница, которую вы пытались открыть по этому адресу, похоже, не существует. Обычно это результат плохой или устаревшей ссылки. Мы приносим свои извинения за доставленные неудобства.

Обычно это результат плохой или устаревшей ссылки. Мы приносим свои извинения за доставленные неудобства.

Что я могу сделать сейчас?

Если вы впервые посещаете TechTarget, добро пожаловать! Извините за обстоятельства, при которых мы встречаемся. Вот куда вы можете пойти отсюда:

Поиск- Узнайте последние новости.

- Наша домашняя страница содержит самую свежую информацию о корпоративном искусственном интеллекте.

- Наша страница «О нас» содержит дополнительную информацию о сайте, на котором вы находитесь, SearchEnterpriseAI.

- Если вам нужно, свяжитесь с нами, мы будем рады услышать от вас.

Просмотр по категории

ПоискБизнесАналитика

- Целенаправленная и стабильная Logi Analytics как часть программного обеспечения Insightware

Бывший независимый специалист по встроенной бизнес-аналитике извлекает выгоду из агрессивной стратегии приобретения своей новой материнской компании как .

..

.. - Запуск Business Analytics Enterprise объединяет инструменты IBM BI

Технический гигант объединил ранее разрозненные возможности на единой платформе и представил новый центр, где клиенты могут просматривать …

- Qlik запускает новую облачную платформу для интеграции данных

Новая интеграционная платформа как услуга объединяет возможности подготовки и каталогизации данных в одном месте, позволяя организациям…

- IRA инвестирует в будущее технологий экологически чистой энергии, работу

Закон о снижении инфляции инвестирует не только в существующие технологии экологически чистой энергии, такие как ветер и солнечная энергия, но и в будущие инновации и …

- Выборы не ускорят антимонопольную реформу и усилия по обеспечению конфиденциальности данных

Результаты промежуточных выборов вряд ли сразу повлияют на ход горячо обсуждаемых антимонопольных законов и законопроектов о реформе Раздела 230 или.

..

.. - Плюсы и минусы Metaverse: основные преимущества и проблемы

Реалистичный опыт, равный доступ, более эффективное сотрудничество и новые возможности для бизнеса, но есть потенциал для повышения …

SearchDataManagement

- Движок данных Speedb делает хранилище ключевых значений открытым исходным кодом

Стартап стремится создать конкурентоспособную альтернативу RocksDB, создав свою технологию обработки данных и сообщество разработчиков…

- Neo4j 5 ускоряет запросы к графовой базе данных

Язык шифровальных запросов значительно улучшился в обновлении базы данных Neo4j 5, что позволяет пользователям выполнять более сложные запросы быстрее, чем …

- Облако данных Snowflake добавляет Python, мультиоблачную совместную работу

Поставщик облачных данных выпустил предварительные обновления для своей платформы, чтобы ускорить запросы данных, улучшить поддержку многооблачных операций.

..

..

ПоискERP

- Активные и пассивные RFID-метки: что выбрать

Как у активных, так и у пассивных RFID-меток есть свои преимущества и недостатки. Организация должна узнать, что они из себя представляют и что они …

- Почему RFID для управления цепочками поставок по-прежнему актуален

RFID — сравнительно старая технология, но она все еще актуальна для управления цепочками поставок. Узнайте о некоторых потенциальных возможностях использования логистики…

- В последней презентации Oracle ERP партнерство с облачными технологиями признано необходимым

Редакторы TechTarget обсуждают новости корпоративных приложений с Oracle CloudWorld 2022 и упор Oracle на партнерские …

Тест Тьюринга (Часть 1) · Эпикурейское лекарство

В связи с вопросом «что делает нас нами?», возможность компьютерного разума часто исследуется в художественной литературе и является горячо обсуждаемой, сложной областью междисциплинарных исследований.

Наша предполагаемая рациональность является одним из наиболее ценных качеств человека, и часто утверждается, что это то, что наиболее четко отличает нас от остальных животных творений… на самом деле… оказывается, существует тесная связь между способностью к концептуальному мышлению и способностью выражать свои мысли на языке и иметь возможность участвовать в процессах рассуждения. Даже шимпанзе, самые умные из нечеловеческих приматов, в лучшем случае, по-видимому, обладают сильно ограниченными способностями к практическим рассуждениям и не проявляют никаких признаков участия в теоретических рассуждениях, которые являются отличительной чертой человеческих достижений в науках. Однако традиционная идея о том, что рациональность является исключительной прерогативой человека, недавно подверглась давлению с двух совершенно разных сторон.

С одной стороны, революция в области информационных технологий привела к амбициозным заявлениям исследователей в области искусственного интеллекта, некоторые из которых утверждают, что правильно запрограммированные компьютеры буквально участвуют в процессах мышления и рассуждений. С другой стороны, по иронии судьбы, некоторые эмпирические психологи начали подвергать сомнению наши собственные человеческие притязания на способность мыслить рационально. Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. [1]

Ведутся серьезные споры о том, что значит сказать, что у машины есть разум. Но это явно не невообразимое предложение; мы видим множество примеров в научной фантастике:

Вот два вопроса, на которые мы, возможно, захотим ответить:

- Что такое признак ментального? т.е. что отличает или определяет ум?

- Как проверить разум?

На первый вопрос можно ответить множеством способов: креативность, рациональность, использование языка, способность испытывать чувства…

(Если вам интересно, мы можем рассказать о некоторых из них в одной из следующих статей. )

)

Что касается второго вопроса, научная фантастика часто дает один и тот же ответ: тест Тьюринга. [2] Но мы забегаем вперед…

А. М. Тьюринг, математик и пионер компьютерной теории, разработал тест, чтобы определить, может ли компьютер думать. Компьютер прошел бы тест, если бы он мог идеально имитировать мыслящего человека, то есть если бы любой, взаимодействующий с ним, был бы обманут, думая, что это человек. Тьюринг сформулировал это в терминах того, что он назвал «игрой в имитацию»:

В «имитацию»… играют три человека: мужчина (А), женщина (В) и следователь (С), которые могут быть любого пола. Следователь остается в комнате отдельно от двух других. Цель игры для следователя состоит в том, чтобы определить, кто из двух других является мужчиной, а кто женщиной… Следователю разрешается задавать вопросы А и Б… Чтобы тон голоса не мог помочь следователю, ответы должны быть написаны, а еще лучше напечатаны на машинке. Идеальный вариант — иметь телетайп, связывающий две комнаты… Теперь зададим вопрос: «Что произойдет, когда машина возьмет на себя роль А в этой игре?» Будет ли следователь принимать неверные решения так же часто, когда игра ведется вот так [между машиной и человеком], как и когда игра ведется между мужчиной и женщиной? Эти вопросы заменяют наш первоначальный вопрос «Могут ли машины думать?» [3]

Или, как это объясняется в одноименном фильме:

youtube.com/embed/Vs7Lo5MKIws?feature=oembed» frameborder=»0″ allow=»autoplay; encrypted-media» allowfullscreen=»»>Чтобы увидеть, как это работает, представьте, что вы заперты в комнате с компьютером. На экране два окна чата, в каждом из которых показан ваш разговор с другим респондентом. Используя компьютер, вы можете отправлять и получать печатные сообщения двум респондентам. Один из них — обычный человек (говорящий на вашем языке). Другая — компьютерная программа, предназначенная для предоставления ответов на ваши вопросы (возможно, чат-бот, такой как Cleverbot). [4] Вам отведено время, скажем, 10 минут, в течение которого вы можете отправить любые вопросы двум респондентам.

Ваша задача попытаться определить на основе их ответов, кто является человеком. Компьютер проходит тест, если вы не можете сказать, что есть что (за исключением случая — тест повторяется, чтобы исключить удачу).

«Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. »

»

Может ли компьютер или программа пройти тест Тьюринга, это эмпирический вопрос, то есть на него можно ответить только путем наблюдения (в отличие от многих философских вопросов, которые мы здесь рассмотрели, это не логический вопрос, на который можно ответить только разумом ). Мы не узнаем, пока не попробуем. И действительно, ежегодно проводится соревнование по тесту Тьюринга, в котором люди используют свои компьютерные программы, чтобы соревноваться вместе с людьми.

На данный момент ни одна компьютерная программа не прошла тест неопровержимо, хотя иногда их ошибочно принимали за людей (существуют споры относительно результатов и того, что они означают). Но это не значит, что компьютер не может. И вымысел признает такую возможность. Мы видим хороший пример проведения теста Тьюринга в британском научно-фантастическом фильме 2013 года «9».0154 The Machine (фильм, который совсем не представлен первыми двумя предложениями его синопсиса в Википедии):

youtube.com/embed/QdmEIDaK7uo?feature=oembed» frameborder=»0″ allow=»autoplay; encrypted-media» allowfullscreen=»»>Позже ученый-компьютерщик проводит еще один тест Тьюринга на гораздо более интересном кандидате — программе, которая, как и Cleverbot, , узнает из разговора (ученый — это следователь, а «зеленый» и «красный» — это «А» и «Б» из имитационной игры Тьюринга):

Ученый: Сейчас я начну тест Тьюринга. Зеленый. Фугли Мантер — хорошее имя для красивой голливудской актрисы; плюшевый мишка; или дизайн свадебного платья?

Зеленый: Плюшевый мишка.

Ученый: Красный. Опишите любовь тремя словами.

Красный: Дом, счастье, размножение.

Ученый: Зеленый.

Зеленый: Счастье, печаль, жизнь.

Ученый: Зеленый. Мэри увидела щенка в окне. Она этого хотела. Чего хотела Мария?

Зеленый: Окно.

Ученый: Почему?

Зеленый: Окна смотрят в мир.

Они красивы и помогают вам чувствовать себя менее одиноким.

(В сторону: какие вопросы вы бы задали, чтобы отличить компьютер от человека? Есть ли вопросы, которые вы могли бы задать, чтобы убедиться, что у чего-то есть разум? [5] )

Зеленый не не пройти тест Тьюринга, но нетрудно представить себе компьютер, который бы это сделал. В Westworld Форд упоминает, что хосты прошли тест Тьюринга в течение первого года. C3PO, синтетика из Alien , сайлоны из Battlestar Galactica — все с честью прошли тест Тьюринга. Действительно, создатель Авы из Ex Machina был настолько уверен, что она пройдет тест Тьюринга, что попросил следователя проверить ее, зная, что она машина:

Калеб: …в тесте Тьюринга машина должна быть скрыта от экзаменатора. А там контрольная, или —

Натан: Я думаю, мы уже прошли это. Если бы я спрятал Аву от тебя, чтобы ты просто слышал ее голос, она бы сошла за человека.

Настоящее испытание — показать вам, что она робот. Затем посмотрите, чувствуете ли вы, что она все еще в сознании.

В конце концов, даже если что-то пройдет тест Тьюринга, этого достаточно? Бар в правильном месте? Обязательно ли прохождение теста означает, что у вас есть разум? Сообщите нам свои мысли в Твиттере или в комментариях, и мы углубимся в эти вопросы во второй части.

[1] Э. Дж. Лоу, Введение в философию разума , (Кембридж: CUP, 2000) с. 193.

[2] Действительно, тест Тьюринга стал сокращением для любого языкового теста, позволяющего отличить людей от машин. Мы рассмотрим некоторые из наших фаворитов в следующем материале.

[3] Алан Тьюринг, Вычислительная техника и интеллект , Разум Том. 59 № 236 (1950), стр. 433-434.

[4] Говоря о чат-ботах, помните, когда Microsoft создала чат-бота и выпустила его в дебрях твиттера?

[5] Потенциально тревожным последствием этого, конечно, является то, что у нас может не быть способа убедиться, что у кого-то еще есть разум, у человека или у машины.

..

.. ..

.. С одной стороны, революция в области информационных технологий привела к амбициозным заявлениям исследователей в области искусственного интеллекта, некоторые из которых утверждают, что правильно запрограммированные компьютеры буквально участвуют в процессах мышления и рассуждений. С другой стороны, по иронии судьбы, некоторые эмпирические психологи начали подвергать сомнению наши собственные человеческие притязания на способность мыслить рационально. Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. [1]

С одной стороны, революция в области информационных технологий привела к амбициозным заявлениям исследователей в области искусственного интеллекта, некоторые из которых утверждают, что правильно запрограммированные компьютеры буквально участвуют в процессах мышления и рассуждений. С другой стороны, по иронии судьбы, некоторые эмпирические психологи начали подвергать сомнению наши собственные человеческие притязания на способность мыслить рационально. Таким образом, нам остается размышлять над странным предположением, что машины нашего изобретения вскоре могут считаться более рациональными, чем их создатели-люди. [1]  Они красивы и помогают вам чувствовать себя менее одиноким.

Они красивы и помогают вам чувствовать себя менее одиноким. Настоящее испытание — показать вам, что она робот. Затем посмотрите, чувствуете ли вы, что она все еще в сознании.

Настоящее испытание — показать вам, что она робот. Затем посмотрите, чувствуете ли вы, что она все еще в сознании.