Подстройка и ведение

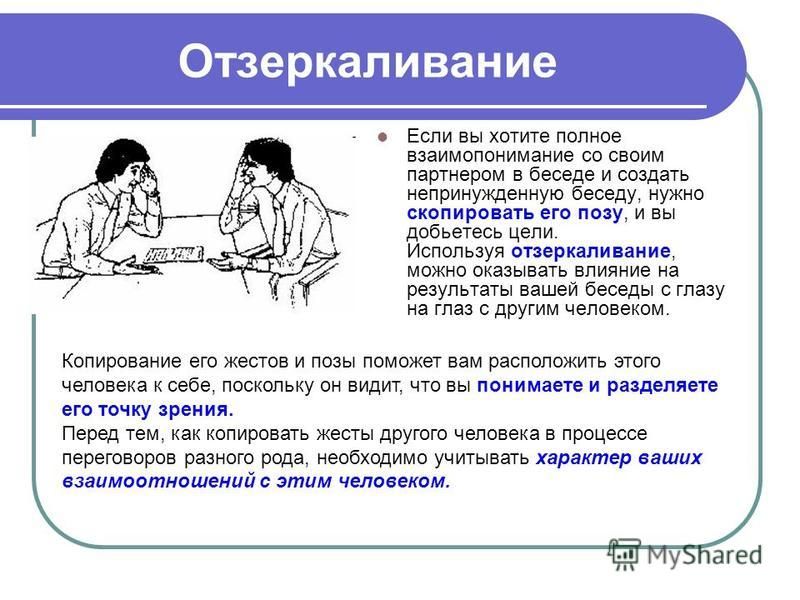

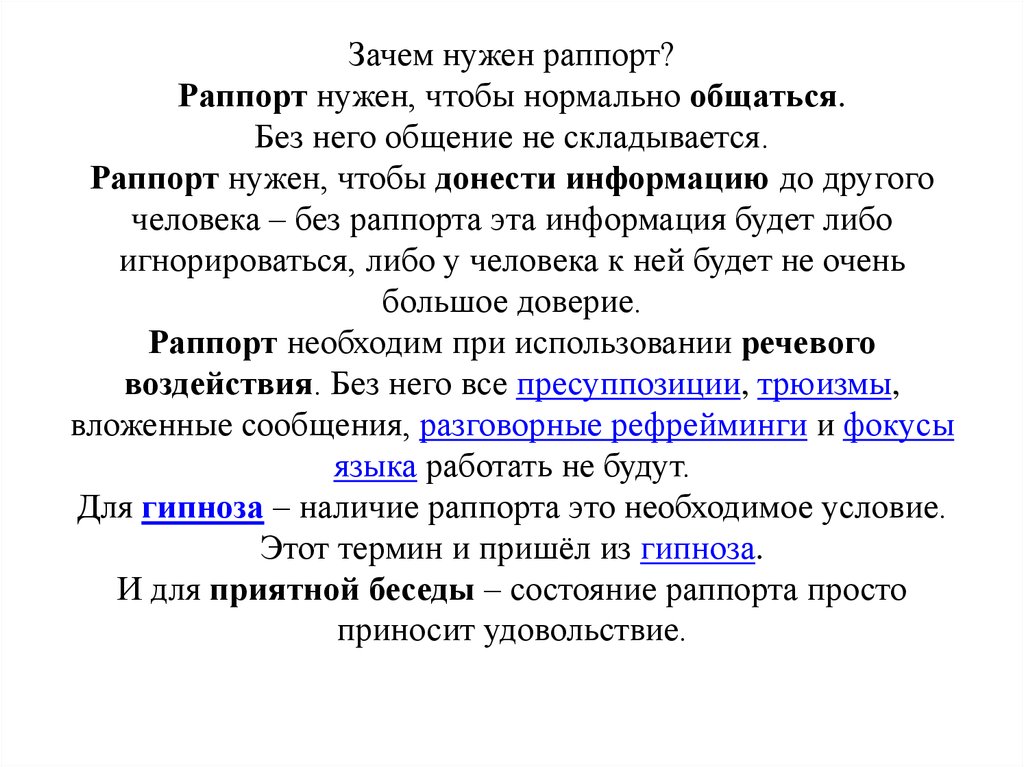

Если вы когда-нибудь наблюдали за тем, как люди общаются друг с другом, вы, вероятно, могли заметить, что временами они начинают имитировать друг друга. Когда при взаимодействии между людьми начинает устанавливаться контакт, часто имеет место согласование определенных действий. Так, они начинают сидеть в одинаковой позе, говорить в одном темпе и одним тоном и даже одинаково жестикулировать. В НЛП этот процесс получил название подстройки. Если вы понаблюдаете внимательно, вы заметите, что при наличии настоящего контакта люди в очень большой степени «отзеркалива-ют» поведение друг друга. Это основной принцип коммуникации, и его можно использовать как средство, позволяющее более эффективно направлять людей.

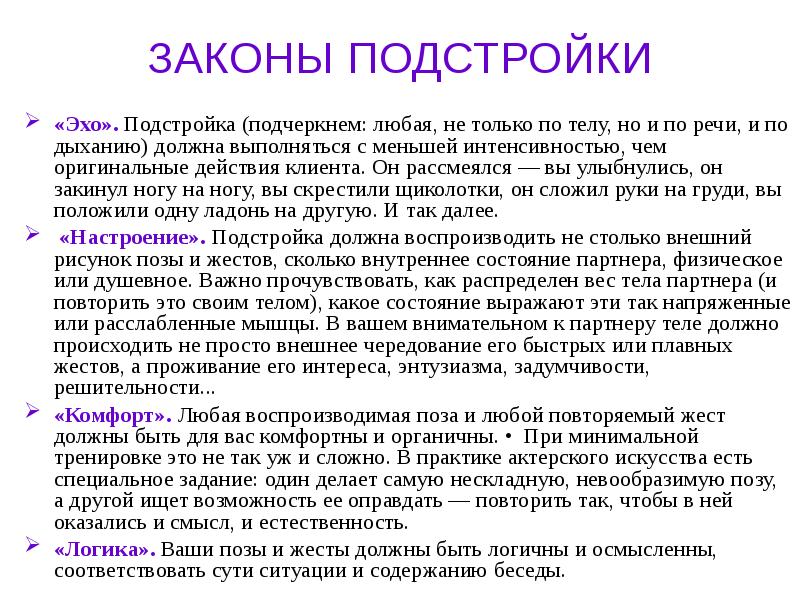

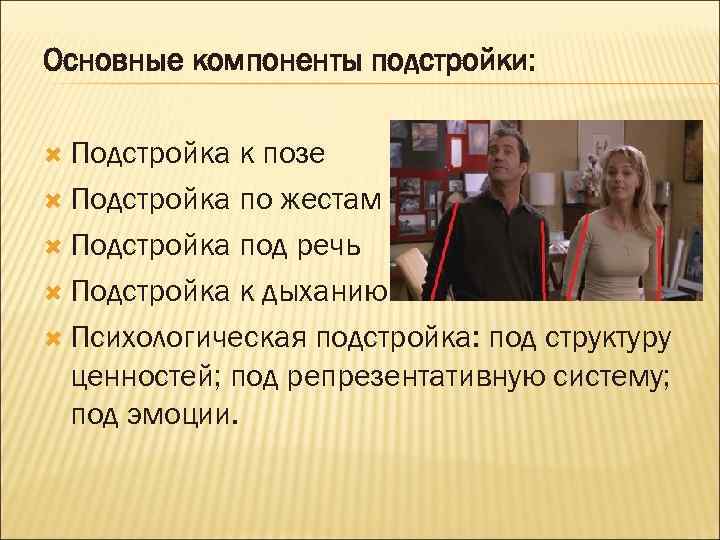

Подстройка — это использование и «отзеркаливание» ключевых вербальных и невербальных сигналов другого человека с целью согласования моделей мира. При этом нужно обладать определенной гибкостью, чтобы выделить характерные особенности лексики и поведения другого человека и ввести их в свою речь и действия.

Например, один из способов установления контакта — «активное слушание», когда вы выделяете языковые паттерны в речи собеседника и используете какие-то из них в ответ. Так, если человек говорит: «У меня есть чувство, что мы должны глубже в этом разобраться», — вы можете сказать в ответ: «Да, понимаю, вы чувствуете, что нам надо заняться этим».

Разумеется, легче подстраиваться к знакомому человеку, с которым у вас уже есть контакт. В этом случае осознание установленного контакта становится чем-то вроде метасообщения. При общении же с незнакомым человеком подстройка может оказаться затруднительной, она может даже выглядеть как проявление неуважения. С другой стороны, она может оказаться очень эффективным способом установить контакт в этом случае.

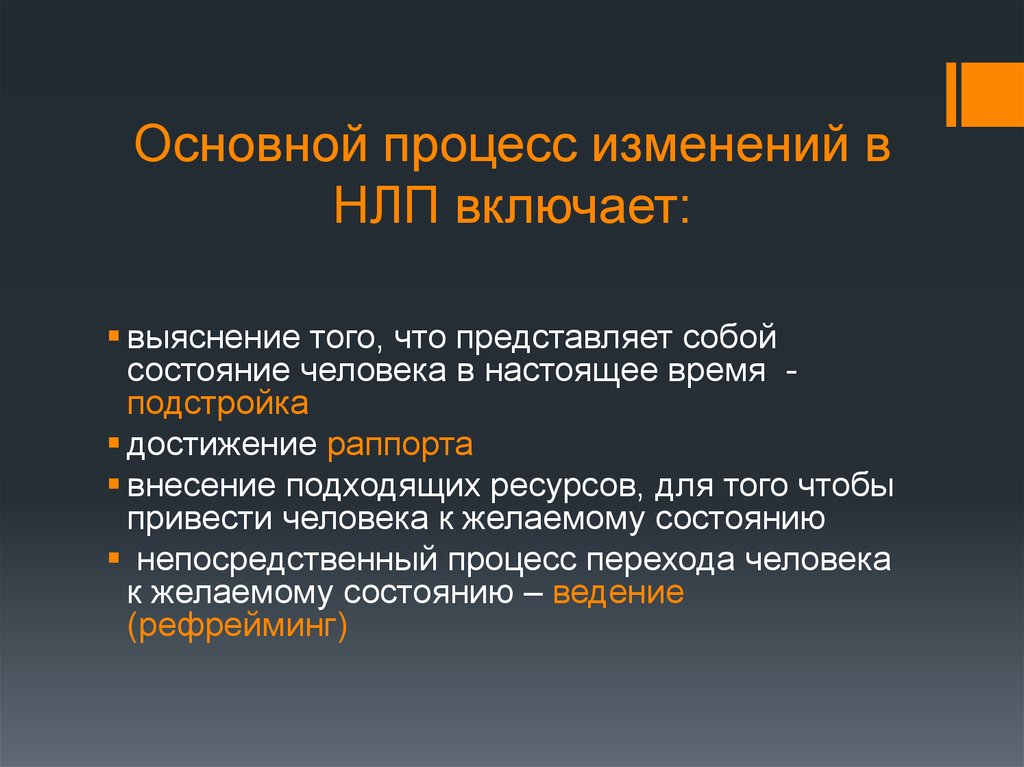

Ведение подразумевает попытку произвести какие-то изменения в другом человеке — расширить или обогатить его поведение или мышление — путем тонких изменений собственных вербальных и невербальных паттернов в желаемом направлении. Основная идея подстройки и ведения — постепенно подвести человека к изменениям в поведении или взгляде на мир, сначала путем согласования и понимания, а затем — расширения его модели мира. Например, когда представляешь нечто новое, то всегда лучше начать с уже знакомого, а потом перейти к этому новому.

Большинство людей думает, что лидерство в первую очередь связано с ведением. Но часто наиболее эффективным лидером оказывается тот, кто, во-первых, может понять модели мира других людей и отнестись к ним с уважением, а во-вторых, обладает достаточной гибкостью, чтобы включить эти другие точки зрения в свое видение. Другими словами, эффективное лидерство требует эффективной подстройки.

Другими словами, эффективное лидерство требует эффективной подстройки.

Хороший пример того, каким влиянием обладает предварительная подстройка на ведение, — случай на одном семинаре по продажам в группе телемаркетинга. Они рассказали про одного покупателя, которому никто не мог ничего продать. Оказалось, что он говорил очень м…е…д…л…е…н..н…о. Поскольку он был президентом большой компании, он мог оказаться очень важным клиентом, так что представители звонили ему и говорили: «Добрый день, сэр. Я знаю, что вы очень заняты, но я отниму только одну минуту вашего времени», — произнося все это примерно в два раза быстрее, чем говорил он.

Но это не совпадало с тем, как он думал и слушал. Чтобы улучшить его навыки коммуникации, участников семинара проинструктировали позвонить ему и сказать: «Добрый день… (очень медленно)… Я из компании Икс… и хотел бы, чтобы вы… уделили мне время… для разгово-ра…когда у вас будет возможность… подумать о нашей продукции… Я знаю, это действительно важно для вас. .. найти время и подумать об этом… Можете ли вы сказать… когда мне лучше перезвонить…» и т. д. Вместо того чтобы говорить: «Это отнимет только минуту», вы говорите: «Когда мне лучше перезвонить, чтобы у вас было достаточно времени, чтобы спокойно и тщательно все обдумать?» Этот человек почувствовал себя настолько комфортно при таком подходе, что назначил встречу, и группа телемаркетинга в конечном итоге получила прибыль.

.. найти время и подумать об этом… Можете ли вы сказать… когда мне лучше перезвонить…» и т. д. Вместо того чтобы говорить: «Это отнимет только минуту», вы говорите: «Когда мне лучше перезвонить, чтобы у вас было достаточно времени, чтобы спокойно и тщательно все обдумать?» Этот человек почувствовал себя настолько комфортно при таком подходе, что назначил встречу, и группа телемаркетинга в конечном итоге получила прибыль.

Как показывает этот пример, одним из важнейших результатов подстройки является установление контакта. Когда люди видят, что вы можете думать так же, как они, и принимаете их слова во внимание, они гораздо меньше сопротивляются новым идеям.

Существует достаточно много способов подстройки. Кроме тембра голоса и темпа речи можно согласовывать ключевые слова и позу.

Один из способов подстройки на очень глубоком уровне — говорить в темпе дыхания собеседника.

Это помогает даже в случаях, когда имеешь дело с проблемными личностями. Например, однажды, когда я делал презентацию на тему коммуникационных навыков, некий человек встал и сказал: «Все, что вы говорите о коммуникации, кажется слишком простым. Я живу в реальном мире, а эти теории хороши только для семинаров. Я не чувствую, что это поможет мне в работе с моими клиентами». На что я ответил: «Ваши возражения вполне законны. Почему бы вам не выйти сюда для демонстрационного упражнения. Представьте, что вы — один из ваших трудных клиентов в реальном мире, а мы попытаемся сделать что-то, чтобы вы вошли с нами в больший контакт».

Я живу в реальном мире, а эти теории хороши только для семинаров. Я не чувствую, что это поможет мне в работе с моими клиентами». На что я ответил: «Ваши возражения вполне законны. Почему бы вам не выйти сюда для демонстрационного упражнения. Представьте, что вы — один из ваших трудных клиентов в реальном мире, а мы попытаемся сделать что-то, чтобы вы вошли с нами в больший контакт».

Он вышел вперед и начал «играть роль». Первое, что я сделал, — осторожно принял похожую позу. Он заявил: «Ну, я человек занятой. Мне приходится общаться с сотней людей каждый день. Многие из них — полные идиоты и только отнимают мое время. Так что давайте побыстрее проделаем все это». Отвечая ему, я начал согласовывать свою речь с его дыханием. Я сказал: «По-моему, это звучит так… как будто вы хотите… чтобы был кто-то, кому вы можете доверять… Кто-то, кто заботится… о ваших потребностях… и будет поддерживать вас… Подумайте о ком-то… кому вы действительно доверяли… в своей жизни… и как вы это чувствовали. … Именно такие отношения… я хотел бы установить с вами». Я продолжал подстраиваться к его дыханию, и в конце концов, спустя примерно три минуты, этот человек остановился и сказал: «Вы знаете, я старался быть таким неуступчивым, каким только смогу, но сейчас я бы купил все, что вы предложите».

… Именно такие отношения… я хотел бы установить с вами». Я продолжал подстраиваться к его дыханию, и в конце концов, спустя примерно три минуты, этот человек остановился и сказал: «Вы знаете, я старался быть таким неуступчивым, каким только смогу, но сейчас я бы купил все, что вы предложите».

Этот пример показывает, какую ценность такие простые, но тонкие невербальные сигналы имеют для установления контакта, подстройки и ведения состояния другого человека, чтобы он стал более открыт для ваших сообщений.

1. Введение. или Подстройка и ведение. Скрытое управление человеком. НЛП в действии

1. Введение. или Подстройка и ведение. Скрытое управление человеком. НЛП в действииВикиЧтение

Скрытое управление человеком. НЛП в действии

Ром Наталья

Содержание

1. Введение. или Подстройка и ведение

Здравствуйте, друзья!

Автор не претендует на эксклюзивность во взглядах на систему скрытого управления человеком и использование методов нейролингвистического программирования.

Однако с уверенностью может сказать, что каждый человек способен научиться многим стратегиям НЛП. И даже одна техника, используемая вовремя, может принести пользы больше, чем любое бездействие!

Управление другим человеком, как и все гениальное должно быть простым и эффективным. Именно для этого существует НЛП. И у Вас будет реальная возможность убедиться в достоинствах приведенных ниже техник.

Если Вы все-таки решитесь изменить свои взаимоотношения с другими людьми, включите техники НЛП в свой арсенал навыков и умений. Начните применять их, и Вы получите позитивные результаты легко и быстро!

Техники НЛП можно менять или комбинировать, что с развитием ваших умений позволит Вам приобрести гибкость, мастерство и творческое отношение к управлению окружающими.

Теперь немного основ об управлении другим человеком с помощью НЛП.

Вы наверняка знаете, что чем больше люди похожи друг на друга, тем более они друг другу симпатичны. Это касается не только внешних признаков, как рост, комплекция и одежда, но и психологических признаков, как поза, жесты, интонации голоса. В этом заключается подсознательные оценки человеком других людей, по принципу «свой – чужой».

В этом заключается подсознательные оценки человеком других людей, по принципу «свой – чужой».

Когда Вы входите в контакт с другими людьми, вы начинаете автоматически согласовывать с ними свои поступки и действия.

При непосредственном контакте вы часто начинаете сидеть в одинаковой позе, говорить с одинаковой интонацией и использовать одинаковые слова и жесты.

В НЛП этот процесс получил название подстройки.

При подстройке вы как радио настраиваетесь на волны, которые излучает собеседник, пытаетесь понять его мысли и чувства, копируете позы и жесты собеседника.

Копирование внешних поведенческих признаков называется отзеркаливание. Понаблюдайте за окружающими и вы обязательно заметите этот поистине магический эффект в процессе общения. Особенно это хорошо заметно у влюбленных пар.

Так вот принцип подстройки под другого человека – это основной принцип взаимодействия в НЛП, и его можно использовать как основу, позволяющую более эффективно управлять другими людьми.

Еще большего эффекта при воздействии на другого человека позволяет достигнуть еще один принцип НЛП. Он называется ведение.

Ведение это высшая форма подстройки и ее прагматичное использование.

Ведение позволяет изменять чувства, мотивы и действия другого человека, расширять и обогащать его поведение, настроение или мышление.

И все это благодаря небольшим, едва уловимым изменениям собственного поведения, благодаря использованию уместных слов, интонаций и жестов, и благодаря последовательному ненавящему наведению человека на нужное направление.

Основная идея подстройки и ведения – постепенно подвести человека к изменениям в поведении или взгляде на мир, сначала путем согласования и понимания, а затем – и расширения его модели мира.

В словах, которые используют люди, заключаются их представления о мире, о других и о себе. Эти слова несут в себе огромную информацию. И использовать ее можно очень эффективно.

Когда вы начинаете использовать ключевые слова, речевые стратегии и метафоры других людей вы присоединяетесь к их внутреннему миру и становитесь для них своим.

Вот здесь и открываются беспредельные возможности для скрытого управления другим человеком.

От Ваших слов зависит очень многое. Речь дана нам, чтобы скрывать свои мысли… И не важно кто это написал.

Важно, что Вы как-то обозначаете ситуацию, и все идет в соответствии со значением Ваших слов, а не наоборот. И ситуация изменяется.

Поверьте, это действительно работает!

И помните, у Вас только один шанс произвести первое впечатление. Любой человек формирует оценку о Вас в течение 10 секунд, так используйте их с максимальной пользой!!!Данный текст является ознакомительным фрагментом.

Подстройка и ведение

Подстройка и ведение

Одно из основных правил процессинга — то, что вы СНАЧАЛА достигаете взаимопонимания с человеком, а ПОТОМ делаете что-то для него. Другими словами, подстраиваетесь и ведете.Подстройка по сути означает, что вы соглашаетесь с человеком в том, что он

Другими словами, подстраиваетесь и ведете.Подстройка по сути означает, что вы соглашаетесь с человеком в том, что он

Ведение

Ведение Когда вы соединяетесь с образом, то есть с вещью, с явлением, входя в него или впуская его в себя, он открывает вам свою суть.Чтобы соединиться с вещью, нужно стихнуть, убрать «я». Так решаются любые

Подстройка и ведение

Подстройка и ведение Вы наверняка не раз замечали, что люди, давно знающие друг друга и симпатизирующие друг другу, нередко ведут себя одинаково: у них одинаковый тембр речи, жесты, мимика и т. д. В связи с этим, в НЛП существует метод подстройки, который заключается в том,

Общие принципы наведения транса (милтон-модель, подстройка и ведение, создание ощущения безопасности у пациента)

Общие принципы наведения транса (милтон-модель, подстройка и ведение, создание ощущения безопасности у пациента)

В работе гипнотерапевта должен быть сведен к минимуму процент неудач. Существует множество эффективных способов индукции гипноза, но овладение такими

Существует множество эффективных способов индукции гипноза, но овладение такими

Подстройка и ведение во время группового обсуждения

Подстройка и ведение во время группового обсуждения Один из способов установить раппорт и обратиться к различным стилям мышления – это привести собственную речь в гармонию с ожиданиями других людей, обращаясь к их особенностям восприятия. Это можно сделать двумя

Ведение

Ведение В настоящее время мы являемся свидетелями того, что в психологии происходят поистине революционные перемены, начало которым было положено около двадцати лет назад. Они явились результатом научных открытий в области семейной терапии, занимавшейся проблемой

Словесная подстройка и ведение: упражнение 5-4-3-2-1

Словесная подстройка и ведение: упражнение 5-4-3-2-1

Сегодня утром вы выполняли словесную подстройку и ведение: говорили три поддающихся проверке предложения, основанных на сенсорных восприятиях, использовали переход и прибавляли не поддающееся проверке предложение. Вы

Вы

Подстройка под позитивный образ

Подстройка под позитивный образ Вы можете, добиваясь своей цели, играть разные роли, в зависимости от ситуации подстраиваясь под нужный образ – тот, на который интересующая вас персона будет позитивно реагировать.Любая роль – это манипуляция собеседником, обман

Подстройка и ведение

Подстройка и ведение Подстройка. Для установления контакта с собеседником вы начинаете его в чем-то копировать. Например, в процессе разговора стараетесь попасть в ритм его дыхания: когда он делает вдох – вы делаете паузу, когда он делает выдох – вы говорите.Что это дает?

Введение в подстройку и ведение

Введение в подстройку и ведение

Сейчас, когда мы уже изучили множество тонкостей и граней раппорта, разобрали по косточкам процесс его построения и поддержания, учли многообразие его влияния на нашу жизнь и научились отстраиваться, начинается самое интересное.

Ведение

Ведение Ведение собеседника – это использование его внутренних установок, или стратегий. Как определить его стратегию? Задайте человеку вопрос и посмотрите, каким образом он на него отвечает. И лучше всего задать вопрос на актуальную для вас тему – к примеру, если вы

Подстройка к будущему

Подстройка к будущему Эту технику хорошо применять, когда у человека проблемы с общением, или ему предстоит выступление перед аудиторией, или он волнуется во время сдачи экзаменов. В общем, когда волнение не помогает и не воодушевляет, а мешает и душит человека. Можно,

Ведение

Ведение

Когда вы соединяетесь с образом, то есть с вещью, с явлением, входя в него или впуская его в себя, он открывает вам свою суть. Чтобы соединиться с вещью, нужно стихнуть, убрать «я». Так решаются любые

Чтобы соединиться с вещью, нужно стихнуть, убрать «я». Так решаются любые

Подстройка под личность

Подстройка под личность Известно, что человек лучше понимает и запоминает те предметы, процессы или информацию, которые воспринимает как полезные, удобные, приятные, нужные. То есть при развитии мышления важно создать правильную эмоциональную установку — вообще говоря,

Подстройка по движению

Подстройка по движению Подстройки по движению я хочу разделить на несколько видов: подстройка по позе,подстройка по жестам и мимике, подстройка по дыханию.Подстройка по позе:Подстройка может быть прямая (правое – правое) и зеркальная (правое – левое), когдаты просто

The Ultimate NLP Tuning FAQ: Sentiment, Topics and More

Lexalytics, компания InMoment, инженер службы поддержки Сара Уильямс отвечает на наиболее часто задаваемые вопросы наших пользователей о том, как настроить наши функции обработки естественного языка.

- Настройка настроений

- Темы запросов

- Категории

- Темы

- Распознавание именованных объектов

- Таксономии

Начинаем!

Настройка тональности

Переписывают ли добавленные (пользовательские) фразы тональности оценки по умолчанию?

Да, пользовательские оценки тональности перезапишут любые оценки Semantria по умолчанию. Вы можете включить сентиментальные фразы, чтобы исправить то, что вы считаете двусмысленной или неправильной полярностью. Например, «симпатичный» может использоваться в контексте «красивое платье» и, следовательно, будет нести в себе положительные эмоции. Тем не менее, слово «симпатичное» можно использовать как нейтральное усиление, например, «это довольно уродливое платье». Поэтому вы можете создать пользовательскую фразу тональности для «симпатичного», где показатель тональности равен «0,0», чтобы перезаписать позитивную тональность по умолчанию.

Я не вижу фраз настроения в моей конфигурации?

Встроенный словарь тональности для Semantria не перечисляет и не показывает все фразы тональности. Если вы не согласны с некоторыми оценками или хотите изменить оценку, чтобы она лучше соответствовала вашему контенту и варианту использования, вы можете добавить эмоциональную фразу.

Если вы не согласны с некоторыми оценками или хотите изменить оценку, чтобы она лучше соответствовала вашему контенту и варианту использования, вы можете добавить эмоциональную фразу.

Какую шкалу следует использовать для оценки выражений тональности?

Мы рекомендуем оставаться в диапазоне от -1 до +1.

Что такое руководство по подсчету очков?

| Тональность | Вес | |

|---|---|---|

| Полный положительный | 1 | идеальный |

| В основном положительный | 0,6 | отличный |

| Слабо положительный | 0,3 | хороший |

| Слегка отрицательный | -0,3 | бедный |

| Преимущественно отрицательный | -0,6 | плохой |

| Полностью отрицательный | -1 | ужасный |

Могу ли я изменить баллы, чтобы они соответствовали моей пользовательской шкале?

Если вы используете Salience, Semantria API или Semantria Excel, вы можете сопоставить наши оценки с собственной шкалой.

Почему я вижу оценки выше или ниже *вставьте значение здесь*?

Показатели тональности не ограничены ни положительным, ни отрицательным пределом. Если документ содержит чрезмерное количество выражений негативного настроения, то оценка тональности документа будет исключительно отрицательной, чтобы отразить это.

Как рассчитываются оценки тональности?

Настроение, представленное простой проекцией непрерывного значения (от -1 до 1) на дискретный набор значений (от очень отрицательного до очень положительного). Движок Salience идентифицирует значения как по сумме, так и по частям. Другими словами, эмоциональный язык в документе будет определяться и оцениваться индивидуально. Затем оценки будут объединены, чтобы определить общую оценку тональности для данного документа. Возьмем для примера этот документ: «Нас обслужили быстро, но официант был груб, а еда была холодной». Компоненты документа имеют положительный тон, но общий тон документа отрицательный.

Являются ли фразы настроений чувствительными к регистру по умолчанию?

Нет, фразы настроения не чувствительны к регистру по умолчанию.

Как сделать оценку тональности чувствительной к регистру?

Добавление ~ перед тональной фразой делает ее чувствительной к регистру.

Можно ли создавать определяемые запросом тональные фразы?

Да. Вы можете сделать это, перейдя к «чувству» на панели настроек и используя логические фразы.

Как работает отрицание?

Если перед тональной фразой стоит такое слово, как «не», «никогда» или что-то, оканчивающееся на «n’t», тональность фразы будет обратной. Положительная фраза станет отрицательной, а отрицательная фраза станет положительной.

Почему *слово или фраза* не инвертируется?

Если что-то следует отрицать, но кажется, что оно не отрицается, это обычно происходит из-за того, что расстояние между отрицателем и фразой настроения слишком велико для шаблона отрицания.

Темы запросов

Являются ли запросы чувствительными к регистру по умолчанию?

№

Как сделать запросы чувствительными к регистру?

Чтобы сделать ключевое слово запроса чувствительным к регистру, добавьте ~ перед ключевым словом и заключите ключевое слово в кавычки. Например, ~»Стив Джобс»

Например, ~»Стив Джобс»

В чем разница между WITH и NEAR?

Оператор WITH требует, чтобы два термина встречались в одном предложении. Оператор NEAR фактически является оператором AND, в котором вы можете контролировать расстояние между словами. Ознакомьтесь с этим ресурсом по синтаксису логических запросов, чтобы узнать больше.

В чем разница между NOTNEAR, NOTWITH и EXCLUDE?

NOTNEAR фактически является оператором NOT, в котором вы можете контролировать расстояние между словами. Оператор NOTWITH требует, чтобы два термина не могли встречаться в одном предложении.

Два термина запроса любого типа могут быть объединены оператором EXCLUDE.

Пример: Йорк ИСКЛЮЧИТЬ «Нью-Йорк».

Эффект отличается от эффекта оператора NOT. Запрос вернет документы со словом «Йорк», за исключением тех, которые содержат только вхождения «Нью-Йорк».

Как скобки используются в запросах?

Если вы сомневаетесь, вы должны использовать круглые скобки в запросах, чтобы устранить путаницу. Возьмем определяемую запросом тему «навигация в аэропорту». Круглые скобки можно использовать для структурирования основных логических фраз следующим образом:

Возьмем определяемую запросом тему «навигация в аэропорту». Круглые скобки можно использовать для структурирования основных логических фраз следующим образом:

((найти ИЛИ искать ИЛИ «идти» ИЛИ найти ИЛИ перемещаться ИЛИ ориентироваться) РЯДОМ/5 (путь ИЛИ ворота ИЛИ терминал)) ИЛИ знак* ИЛИ потерян ИЛИ табличка* ИЛИ карта ИЛИ навигация ИЛИ шаттл* ИЛИ авиапоезд* ИЛИ «авиапоезд*» ИЛИ автобус

Категории и темы понятий

В чем разница между категориями и темами понятий?

Нет никакой разницы! Категории называются темами концепций в Semantria Excel.

В чем разница между категориями и запросами?

В отличие от запросов, категории не основаны на совпадении фраз. Категории создают свои оценки релевантности на основе матрицы понятий. Например, если вы включаете в запрос термин «еда», механизм Salience будет сопоставлять только контент, который содержит точное слово «еда». и суп — даже если в документе термин «еда» не упоминается явно.

Что такое концептуальная матрица?

Матрица понятий использует связи между статьями Википедии™ для разработки матрицы семантических ассоциаций между ключевыми словами и фразами, формируя всеобъемлющую сеть больших понятий, тем и объектов, которые являются ответвлениями каждого понятия, и связей между всеми этими понятиями. статьи.

статьи.

Подумайте об этом так: одна статья в Википедии о политической партии может содержать десятки ссылок на другие статьи, связанные с концепцией политики. Каждая из этих статей, в свою очередь, содержит ссылки на другие страницы и так далее. Чем ближе статья в этой цепочке к исходной теме, тем теснее она связана с этой темой и тем сильнее ассоциация.

Лучшие практики для категорий?

Хотя вы можете создавать длинные и сложные концептуальные запросы, мы не рекомендуем это делать. Помимо того, что это проблема для обслуживания, результаты обычно ухудшаются по мере усложнения. Лучшее решение часто состоит в том, чтобы разбивать очень широкие темы на более мелкие подтемы и сопоставлять эти подтемы вместе в потребляющем приложении. То есть вместо того, чтобы иметь одну категорию для всего «Бизнеса», вы можете получить лучшие результаты, используя «человеческие ресурсы», «соблюдение нормативных требований» и т. д. по отдельности.

В чем разница между категориями и автоматическими категориями?

Автоматические категории имеют подкатегории, а пользовательские категории — нет. Кроме того, автокатегории не являются частью таксономии, в то время как категории могут быть частью таксономии.

Кроме того, автокатегории не являются частью таксономии, в то время как категории могут быть частью таксономии.

Что такое Boost Value на вкладке Configurations?

Повышенное значение — это множитель, который применяется к показателю релевантности, выдаваемому механизмом значимости для категорий. Это полезно, потому что иногда, независимо от того, что вы делаете, категория всегда возвращает низкий показатель релевантности. Поскольку мы призываем наших пользователей устанавливать порог релевантности, чтобы отсеять нерелевантные темы, мы разработали способ повышения категорий. Это помогает клиентам поддерживать разумный порог релевантности, помогая тем категориям, у которых всегда низкие оценки, преодолевать этот порог.

Что такое оператор CONTEXT в категориях?

В то время как оператор НЕ исключает определенные идеи, подразумеваемые запросом, КОНТЕКСТ выделяет эти идеи. Представьте, что вы анализируете документы, связанные с производством автомобилей. Запрос «автомобили, производство», вероятно, соответствует многим понятиям, относящимся к производству автомобилей. Тем не менее, это также может привести к статьям об общем производстве. Альтернативный запрос «automobile_manufacturing» очень специфичен, возможно, даже слишком.

Тем не менее, это также может привести к статьям об общем производстве. Альтернативный запрос «automobile_manufacturing» очень специфичен, возможно, даже слишком.

Создание запроса «Автомобильный КОНТЕКСТ производства» приведет к поиску автомобилей в целом с упором на производство. Он не будет возвращать результаты об общем производстве.

В частности, текст к левому КОНТЕКСТА дает общую идею, которую ищут, а текст к правому дает идеи, которые вы хотите обсудить с этой темой.

Как настроить категории?

[perfectpullquote align=»right» bordertop=»false» cite=»» link=»» color=»#c3c7c7″ class=»» size=»»] Точность : количество правильных совпадений ÷ (количество правильных совпадений + количество неправильных совпадений)

Отзыв : количество правильных совпадений ÷ (количество правильных совпадений + количество пропущенных совпадений) [/perfectpullquote]

Во время быстрой разработки категорий и концептуальных запросов достаточно специального анализа результатов.

Однако, если целью является оптимальная производительность и надежные результаты, формальное тестирование рекомендуется. Вы можете использовать достоверные статистические данные для принятия решений. Попробуйте аннотировать набор документов, указав категории, которым вы хотите соответствовать (например, производство автомобилей). Затем вы можете вычислить 9Точность 0114 и отзыв для каждого запроса.

С помощью этих аннотаций вы можете вносить небольшие изменения в определения и веса категорий и смотреть, улучшатся ли ваши результаты. Вы также можете определить любые понятия, с которыми у Матрицы понятий возникают трудности, специально обратившись к этим запросам. Для этого разбейте тему на определенные подтемы или просто вернитесь к более традиционным темам, основанным на запросах.

Темы

Почему я не могу настроить Темы?

Темы — это именные словосочетания, основанные на именах не собственных. Настройка тем требует от пользователя понимания грамматических структур и шаблонов PoS (часть речи). Обычный пользователь Semantria не выиграет от манипулирования этими шаблонами. Кроме того, нет белого списка тем; вы должны иметь возможность захватывать фразы, которые вы хотите, с помощью тега Lexalytics PoS.

Обычный пользователь Semantria не выиграет от манипулирования этими шаблонами. Кроме того, нет белого списка тем; вы должны иметь возможность захватывать фразы, которые вы хотите, с помощью тега Lexalytics PoS.

Как Semantria решает, что Тема существует?

Путем сопоставления шаблонов PoS, определенных в файле rules.ptn в каталоге Themes в Salience. Файл rules.ptn не доступен для пользователей в Semantria. Есть пять различных шаблонов, которые будут соответствовать фразе с несобственным существительным в качестве темы.

Зависят ли темы сущностей от существования тем?

Да, иначе это не Тема.

Тема Entity — это просто тема, связанная с извлеченной сущностью, как определено движком Salience.

Каковы оценки тональности тем? Что они указывают?

Подобно темам, объектам, фразам и категориям, темы имеют вес настроений (положительных, отрицательных, нейтральных). Когда механизм Salience идентифицирует тему в текстовом документе, он определяет, несет ли эта тема тональность. Теперь пользователь знает, обсуждается ли тема в положительном или отрицательном (или нейтральном) ключе.

Теперь пользователь знает, обсуждается ли тема в положительном или отрицательном (или нейтральном) ключе.

Именованные сущности

Являются ли сущности чувствительными к регистру по умолчанию?

Нет, по умолчанию сущности не чувствительны к регистру.

Что такое объекты, определяемые запросом?

Сущности, определяемые запросом, — это способ привлечения механизма фильтрации Lexalytics к обнаружению сущностей. Контекст может быть важен для идентификации сущности. Известные люди делятся именами. Продукты могут быть названы с использованием общих слов, которые появляются в разных контекстах. В этих ситуациях простого сопоставления текста Entity недостаточно: вы также должны убедиться, что контекст является ожидаемым. В то время как флаги доверия могут обрабатывать простые бинарные ситуации, объекты, определяемые запросом, предоставляют возможность создавать очень точно настроенные правила сущностей.

В отличие от обычных объектов, объекты, определяемые запросом, могут перекрываться. Это может быть полезно для сущностей, пересекающих границы типа (Бостон Ред Сокс как спортивная команда и как упоминание города), или для создания различных правил для сущности в зависимости от контекста. Например, вы можете создать две отдельные нормализации для Арнольда Шварценеггера. Используя Query Defined Entities, разделите данные между обсуждениями его политической карьеры и его кинокарьеры. Статья, в которой обсуждаются оба, будет соответствовать обоим контекстам и возвращать обе формы Entity.

Это может быть полезно для сущностей, пересекающих границы типа (Бостон Ред Сокс как спортивная команда и как упоминание города), или для создания различных правил для сущности в зависимости от контекста. Например, вы можете создать две отдельные нормализации для Арнольда Шварценеггера. Используя Query Defined Entities, разделите данные между обсуждениями его политической карьеры и его кинокарьеры. Статья, в которой обсуждаются оба, будет соответствовать обоим контекстам и возвращать обе формы Entity.

Как определить сущность с помощью запроса?

Создание объектов, определенных запросом, в конфигурациях очень просто. В поле «Сущность» объекта просто начните запрос с символа «+» (например, +Apple Inc.).

Что такое этикетка?

Поле метки, возвращаемое в выходных данных API, содержит дополнительную информацию об объекте, например ссылку на страницу Википедии. Это полезно, если вы хотите лучше понять, как Semantria пришла к такому решению.

Что такое тип?

Поле «Тип», обычно используемое для различения типов сущностей друг от друга, может содержать такую информацию, как «Компания», «Человек», «Продукт» и т. д.

д.

Что означает нормализованное значение?

Вы можете использовать Normalize Value для нормализации различных форм Entity до одного и того же значения. Например, одним объектом может быть Coke, а другим Coca-Cola. Вы можете захотеть нормализовать оба из них на «Coke». Если вы введете одно и то же нормализованное значение для каждой сущности, они будут отображаться в выводе как одно и то же.

Таксономии

Каково назначение таксономий?

Целью таксономий Lexalytics является обеспечение иерархической категоризации, которая недоступна в какой-либо отдельной функции. Таксономии позволяют пользователю реализовывать перекрестные иерархии функций, поскольку запросам категории и темы можно назначить узел в таксономии.

Что входит в таксономию?

Пользователь создает свою собственную иерархию узлов и назначает запросы темы и/или категории любому узлу, который он хочет. Эти тематические запросы и категории называются «листьями». Таксономический узел может выглядеть следующим образом: [Персонал отеля] → [Консьерж] → [Отношение консьержа] → (Отношение консьержа), где [] представляет собой узел, а () представляет собой лист.

Каковы некоторые рекомендации по таксономии?

Всегда помните о концепции точности и отзыва при создании определений узлов. Лучше не делать определения узлов слишком строгими. Если это произойдет, узел почти не получит совпадений, что сделает его статистически незначимым. С другой стороны, также лучше избегать слишком широких определений узлов, так как это может заглушить любой сигнал шумом.

Повышение производительности модели NLP с помощью автоматической настройки модели в Amazon SageMaker

по Джейсон Чжу, Кайл Брубейкер и Сяофэй Ма | на | в Amazon SageMaker, искусственный интеллект | Постоянная ссылка | Комментарии | Делиться За последние два года в области обработки естественного языка (NLP) произошло много замечательных прорывов. Усовершенствованные модели глубокого обучения повышают современные стандарты производительности для задач НЛП. Чтобы извлечь выгоду из недавно опубликованных моделей НЛП, лучше всего применить предварительно обученную языковую модель к новому набору данных и настроить ее для конкретной задачи НЛП. Этот подход известен как передача обучения , что может значительно снизить требования к ресурсам для обучения модели по сравнению с обучением модели с нуля, а также может дать достойные результаты даже с небольшими объемами обучающих данных.

Чтобы извлечь выгоду из недавно опубликованных моделей НЛП, лучше всего применить предварительно обученную языковую модель к новому набору данных и настроить ее для конкретной задачи НЛП. Этот подход известен как передача обучения , что может значительно снизить требования к ресурсам для обучения модели по сравнению с обучением модели с нуля, а также может дать достойные результаты даже с небольшими объемами обучающих данных.

В связи с быстрым развитием методов НЛП было разработано множество сред НЛП с упакованными предварительно обученными языковыми моделями, чтобы предоставить пользователям легкий доступ к передаче обучения. Например, ULMFiT от fast.ai и PyTorch-Transformers от Hugging Face — это две популярные платформы НЛП с предварительно обученными языковыми моделями.

В этом посте показано, как точно настроить модели NLP с помощью PyTorch-Transformers в Amazon SageMaker и применить встроенную возможность автоматической настройки моделей для двух наборов данных NLP: Microsoft Research Paraphrase Corpus (MRPC) [1] и Stanford Question Answering. Набор данных (SQuAD) 1.1 [2]. PyTorch-Transformers — это библиотека с набором современных предварительно обученных языковых моделей, включая BERT, XLNET и GPT-2. В этом посте используется его предварительно обученная базовая модель BERT (представления двунаправленного кодировщика от трансформаторов), разработанная Google [3].

Набор данных (SQuAD) 1.1 [2]. PyTorch-Transformers — это библиотека с набором современных предварительно обученных языковых моделей, включая BERT, XLNET и GPT-2. В этом посте используется его предварительно обученная базовая модель BERT (представления двунаправленного кодировщика от трансформаторов), разработанная Google [3].

| Об этом сообщении в блоге | |

| Время чтения | 10 минут |

| Время завершения | ~ 20 часов |

| Стоимость завершения | ~ 160 долларов США (на момент публикации) |

| Уровень обучения | Расширенный (300) |

| Сервисы AWS | Amazon SageMaker Amazon S3 |

Подробное пошаговое руководство по коду можно найти в блокноте с примерами.

Этот пост демонстрирует, как сделать следующее:

- Запустите Git-код PyTorch-Transformers в Amazon SageMaker, который может работать на вашем локальном компьютере, используя платформу SageMaker PyTorch.

- Оптимизация гиперпараметров с помощью автоматической настройки модели в Amazon SageMaker.

- Просмотр чувствительности моделей НЛП к значениям гиперпараметров.

Настройка преобразователей PyTorch

В этом посте используется экземпляр блокнота ml.t2.medium. Общие сведения об Amazon SageMaker см. в разделе Начало работы с Amazon SageMaker.

В этом сообщении в качестве примера используется набор данных MRPC General Language Understanding Evaluation (GLUE), чтобы пройтись по ключевым шагам, необходимым для интеграции PyTorch-Transformer в Amazon SageMaker, а также для точной настройки модели с использованием контейнера SageMaker PyTorch. Чтобы настроить PyTorch-Transformer, выполните следующие шаги:

- Загрузите данные GLUE, запустив скрипт download_glue_data.

py в репозитории GitHub и распаковав его в каталог

py в репозитории GitHub и распаковав его в каталог $GLUE_DIR. Следующий пример кода в блокноте Jupyter загружает данные и сохраняет их в папку с именемGlue_data:!python download_glue_data.py --data_dir Glue_data --задачи все

- Скопируйте код PyTorch-Transformer GitHub в локальный каталог экземпляра блокнота Amazon SageMaker. См. следующий код:

!git clone https://github.com/huggingface/pytorch-transformers.git

После этих двух шагов у вас должна быть папка данных с именем

Glue_Dataи папка сценария с именемpytorch-transformersв каталоге ваш блокнот Jupyter. - Точная настройка модели BERT для набора данных MRPC. Используйте сценарий

run_glue.py, предоставленный в/pytorch-transformers/example/, в качестве обучающего сценария для оценщика PyTorch в Amazon SageMaker.

Перед созданием оценщика внесите следующие изменения:

- Проверьте и измените код argparse в

run_glue., чтобы средство оценки SageMaker могло считывать входные аргументы как гиперпараметры. Например, вы можете рассматривать py

py do_trainиdo_evalкак гиперпараметры и передавать им логическое значение при вызове оценщика PyTorch в Amazon SageMaker. - Создайте файл

requirements.txtв том же каталоге, что и обучающий скриптrun_glue.py. Файлrequirements.txtдолжен включать пакеты, необходимые для сценария обучения, которые еще не установлены по умолчанию в контейнере Amazon SageMaker PyTorch. Например,pytorch_transformers— это один из пакетов, которые необходимо установить.

Файл requirements.txt — это текстовый файл, содержащий список необходимых пакетов, устанавливаемых с помощью установщика пакетов Python, в данном случае пункт . При запуске учебных заданий контейнер Amazon SageMaker автоматически ищет файл requirements. в исходной папке скрипта и использует  txt

txt pip install для установки пакетов, перечисленных в этом файле.

Тонкая настройка модели НЛП в Amazon SageMaker

После загрузки данных и подготовки сценария обучения вы готовы к точной настройке модели НЛП в Amazon SageMaker. Чтобы запустить задание обучения, выполните следующие шаги:

- Загрузите данные в Amazon S3. См. следующий код:

входы = sagemaker_session.upload_data (путь = data_dir, ведро = ведро, key_prefix = s3_prefix)

- Настройте переменные среды обучающего сценария и начальные настройки гиперпараметров. См. следующий код:

container_data_dir = '/opt/ml/input/data/training' container_model_dir = '/opt/ml/model' параметры = { 'model_type': 'берт', 'model_name_or_path': 'bert-base-uncased', 'имя_задачи': имя_задачи, 'data_dir': container_data_dir, 'output_dir': container_model_dir, 'num_train_epochs': 3, 'per_gpu_train_batch_size': 64, 'per_gpu_eval_batch_size': 64, 'сохранить_шагов': 150, 'log_steps': 150 # здесь вы можете добавить дополнительные входные аргументы }В приведенном выше коде каталоги контейнеров для входных данных (

/opt/ml/input/data/training) и артефактов модели (/opt/ml/model) передаются сценарию обучения. Вы указываете каталоги, относящиеся к контейнеру, а не локальные каталоги, поскольку Amazon SageMaker выполняет задание обучения в контейнере Docker. Чтобы запустить задание обучения, вам необходимо передать путь S3 данных обучения функции estimator.fit() . В процессе создания контейнера Amazon SageMaker автоматически загружает данные S3 и сохраняет их в каталогах, определенных переменными среды контейнера.

Вы указываете каталоги, относящиеся к контейнеру, а не локальные каталоги, поскольку Amazon SageMaker выполняет задание обучения в контейнере Docker. Чтобы запустить задание обучения, вам необходимо передать путь S3 данных обучения функции estimator.fit() . В процессе создания контейнера Amazon SageMaker автоматически загружает данные S3 и сохраняет их в каталогах, определенных переменными среды контейнера.Важно знать правильное расположение входных и выходных данных модели в контейнере Amazon SageMaker Docker. Для ввода модели используйте

/opt/ml/input/data/channel_name/, где пользователь указываетимя_канала(например,обучениеилитестирование). Для артефактов модели используйте/opt/ml/model/. Дополнительные сведения см. в статьях Контейнеры Amazon SageMaker: библиотека для создания контейнеров Docker и Создание собственного контейнера алгоритмов в репозитории GitHub.Сценарий обучения

run_glue.загружает данные обучения и проверки из одного и того же каталога, поэтому вам нужно только определить один каталог данных и пометить имя канала как py

py training. Файл журнала модели и артефакты обученной модели сохраняются в каталоге/opt/ml/model/в контейнере Docker и загружаются в S3 после завершения задания обучения. - Создайте средство оценки PyTorch и запустите задание обучения. См. следующий код:

из sagemaker.pytorch импортировать PyTorch оценка = PyTorch (entry_point = 'run_glue.py', source_dir = './pytorch-transformers/examples/', гиперпараметры=параметры, роль = роль, framework_version='1.1.0', train_instance_count=1, train_instance_type=’ml.p3.2xlarge’ ) estimator.fit({'обучение': входные данные})Задание обучения для предыдущего примера занимает примерно пять минут.

Вы должны увидеть задание обучения, запущенное на вкладке сеанса Задания обучения в консоли Amazon SageMaker. Выбрав задание обучения, вы можете просмотреть подробную информацию о выполнении обучения, включая журналы Amazon CloudWatch и ссылку на местоположение S3 для выходных данных модели и артефактов.

Вы должны увидеть задание обучения, запущенное на вкладке сеанса Задания обучения в консоли Amazon SageMaker. Выбрав задание обучения, вы можете просмотреть подробную информацию о выполнении обучения, включая журналы Amazon CloudWatch и ссылку на местоположение S3 для выходных данных модели и артефактов.

Запуск автоматической настройки модели

Протестируйте настройку обучения, выполнив одно полное задание обучения без ошибок. Затем вы можете запустить автоматическую настройку модели с помощью байесовской оптимизации, выполнив следующие шаги:

- Определите показатель оптимизации. Amazon SageMaker поддерживает предопределенные метрики, которые он может автоматически считывать из журнала обучения CloudWatch, который существует для встроенных алгоритмов (таких как XGBoost) и платформ (таких как TensorFlow или MXNet). При использовании собственного сценария обучения необходимо указать Amazon SageMaker, как извлечь показатель из журнала с помощью простого регулярного выражения.

См. следующий код:

См. следующий код:metric_definitions = [{'Имя': 'f1_score', 'Regex': '\'f1_\': ([0-9\\.]+)'}]Измените

run_glue.py, чтобы убедиться, что результаты оценки модели распечатываются в журнале CloudWatch. В этом посте используйте показатель F1 в качестве метрики оптимизации для автоматической настройки модели. - Определите диапазон гиперпараметров. См. следующий код:

гиперпараметр_диапазоны = { 'learning_rate': ContinuousParameter (5e-06, 5e-04), scaling_type = "Логарифмический") }Для больших моделей НЛП лучше ограничить работу по настройке одним или двумя гиперпараметрами за раз, чтобы байесовская оптимизация была стабильной и могла сходиться быстрее. Также имейте в виду, что для разных значений гиперпараметров могут потребоваться разные вычислительные ресурсы. Например, размер пакета для моделей глубокого обучения напрямую влияет на объем памяти ЦП/ГП, необходимый для обучения модели.

Установка диапазона гиперпараметров, совместимого с емкостью обучающего экземпляра EC2, является хорошей практикой и помогает обеспечить плавную настройку модели.

Установка диапазона гиперпараметров, совместимого с емкостью обучающего экземпляра EC2, является хорошей практикой и помогает обеспечить плавную настройку модели. - Запустить задание настройки гиперпараметров. См. следующий код:

из sagemaker.tuner импортировать HyperparameterTuner target_metric_name = 'f1_score' тюнер = ГиперпараметрТунер(оценщик, target_metric_name, гиперпараметр_диапазоны, метрика_определения, стратегия = «байесовская», target_type = 'Максимум', макс_работ = 30, max_parallel_jobs=3, Early_stopping_type = 'Авто') tuning_job_name = "pt-bert-mrpc-{}".format(strftime("%d-%H-%M-%S", gmtime())) Tuner.fit({'обучение': входы}, job_name=tuning_job_name) тюнер.wait()

Вы можете следить за ходом задания по настройке в консоли Amazon SageMaker. Дополнительные сведения см. в разделе Мониторинг хода выполнения задания по настройке гиперпараметров.

Дополнительные сведения см. в разделе Мониторинг хода выполнения задания по настройке гиперпараметров.

Результаты автоматической настройки модели для набора данных GLUE MRPC

Вы можете легко извлечь результаты настройки гиперпараметров в кадр данных для дальнейшего анализа. См. следующий код:

tuning_metrics = sagemaker.HyperparameterTuningJobAnalytics(tuning_job_name).dataframe()

На следующих графиках показано изменение скорости обучения и оценки модели F1 по сравнению с заданиями обучения, упорядоченными по времени начала задания обучения. Процесс байесовской оптимизации задается с использованием трех параллельных заданий на 10 итераций (всего 30 заданий обучения). Для автоматической настройки модели потребовалось 15 учебных заданий (пять итераций), чтобы найти оптимальную скорость обучения, а затем точно отрегулировать скорость обучения до значения 6,5e-5, чтобы максимизировать оценку F1.

На следующем графике показана оценка F1 в зависимости от скорости обучения и показана чувствительность модели к гиперпараметрам. Результаты получены из набора данных MRPC dev с использованием предварительно обученной базовой модели BERT uncase.

Результаты получены из набора данных MRPC dev с использованием предварительно обученной базовой модели BERT uncase.

Показатель F1 может широко варьироваться от 0,75 до 0,92 для скорости обучения от 1e-5 до 5e-4. График также показывает, что оптимальная скорость обучения составляет 6,47e-5, а показатель F1 достиг пика 0,918 для проверочного набора данных. Большинство обучающих заданий (22 из 30 заданий) проводились вблизи оптимального значения скорости обучения, что свидетельствует о хорошей эффективности байесовского алгоритма оптимизации.

Результаты автоматической настройки модели для набора данных SQuAD

Вы можете выполнить аналогичную автоматическую настройку модели для набора данных SQuAD 1.1, набора из 100 000 пар вопросов и ответов, полученных из краудсорсинга. Тонкая настройка набора данных SQuAD демонстрирует настройку гиперпараметров для другой задачи NLP, а также для набора данных, превышающего данные MRPC, который представляет собой набор примерно из 5000 пар предложений. Детали кода можно найти в блокноте.

Детали кода можно найти в блокноте.

На следующих графиках показан процесс настройки гиперпараметров так же, как и результаты MRPC. Обучение имеет немного другие настройки и использует два параллельных задания для 15 итераций (всего 30 заданий). Опять же, байесовская оптимизация может быстро найти оптимальную скорость обучения (около 5,7e-5) после восьми заданий (четыре итерации). На задании 20 также наблюдается всплеск, но затем задания по настройке быстро сходятся к оптимальной скорости обучения. Всплеск на работе 20 может быть связан с рандомизацией в байесовском алгоритме оптимизации, который, как правило, предотвращает подгонку локального минимума/максимума.

Как и в случае с MRPC, модель SQuAD также сильно чувствительна к значениям гиперпараметров. Следующий график зависимости F1 от скорости обучения показывает красивую параболическую форму с оптимальной скоростью обучения 5,73e-5. Соответствующая оценка F1 составляет 0,884, а точное совпадение (EM) — 0,812, что аналогично исходному документу BERT, сообщающему о F1 на уровне 0,885 и EM на уровне 0,808 для набора данных разработчиков SQuAD 1. 1.

1.

Мы использовали меньший размер партии (16) и одну эпоху при настройке модели по сравнению с размером партии 32 и тремя эпохами, используемыми в статье BERT [3].

Уборка

Во избежание дополнительных расходов остановите экземпляр записной книжки и удалите артефакты модели, сохраненные в S3.

Заключение

В этом посте показано, как точно настроить модели NLP с помощью библиотеки PyTorch-Transformers Hugging Face в Amazon SageMaker, а также продемонстрирована эффективность использования встроенной автоматической настройки модели в Amazon SageMaker для максимизации производительности модели за счет оптимизации гиперпараметров. Такой подход упрощает внедрение современных языковых моделей для задач НЛП и достижение новых рекордов точности в НЛП с помощью возможностей автоматической настройки моделей в Amazon SageMaker.

Каталожные номера:

[1] Алекс Ван, Аманприт Сингх, Джулиан Майкл, Фе-ликс Хилл, Омер Леви и Сэмюэл Боуман. « GLUE: многозадачная платформа для тестирования и анализа естественного языка. » Препринт arXiv arXiv: 1804.07461 (2018)

« GLUE: многозадачная платформа для тестирования и анализа естественного языка. » Препринт arXiv arXiv: 1804.07461 (2018)

[2] Пранав Раджпуркар, Цзянь Чжан, Константин Лопырев и Перси Лян. «Отряд : более 100 000 вопросов для машинного понимания текста. » Препринт arXiv arXiv: 1606.05250 (2016)

[3] Джейкоб Девлин, Минг-Вей Чанг, Кентон Ли, Кристина Тутанова. « BERT: предварительная подготовка глубоких двунаправленных преобразователей для понимания языка. » Препринт arXiv arXiv: 1810.04805 (2018)

Об авторах

Джейсон Чжу (Jason Zhu ) — специалист по данным в AWS Professional Services, специализирующийся на помощи клиентам с использованием машинного обучения. В свободное время он любит проводить время на свежем воздухе и развивать свои кулинарные способности.

Сяофей Ма — научный сотрудник AWS AI Labs, специализирующийся на разработке сервисов на основе машинного обучения для клиентов AWS.

py в репозитории GitHub и распаковав его в каталог

py в репозитории GitHub и распаковав его в каталог  py

py  Вы указываете каталоги, относящиеся к контейнеру, а не локальные каталоги, поскольку Amazon SageMaker выполняет задание обучения в контейнере Docker. Чтобы запустить задание обучения, вам необходимо передать путь S3 данных обучения функции estimator.fit() . В процессе создания контейнера Amazon SageMaker автоматически загружает данные S3 и сохраняет их в каталогах, определенных переменными среды контейнера.

Вы указываете каталоги, относящиеся к контейнеру, а не локальные каталоги, поскольку Amazon SageMaker выполняет задание обучения в контейнере Docker. Чтобы запустить задание обучения, вам необходимо передать путь S3 данных обучения функции estimator.fit() . В процессе создания контейнера Amazon SageMaker автоматически загружает данные S3 и сохраняет их в каталогах, определенных переменными среды контейнера. py

py  Вы должны увидеть задание обучения, запущенное на вкладке сеанса Задания обучения в консоли Amazon SageMaker. Выбрав задание обучения, вы можете просмотреть подробную информацию о выполнении обучения, включая журналы Amazon CloudWatch и ссылку на местоположение S3 для выходных данных модели и артефактов.

Вы должны увидеть задание обучения, запущенное на вкладке сеанса Задания обучения в консоли Amazon SageMaker. Выбрав задание обучения, вы можете просмотреть подробную информацию о выполнении обучения, включая журналы Amazon CloudWatch и ссылку на местоположение S3 для выходных данных модели и артефактов. См. следующий код:

См. следующий код: Установка диапазона гиперпараметров, совместимого с емкостью обучающего экземпляра EC2, является хорошей практикой и помогает обеспечить плавную настройку модели.

Установка диапазона гиперпараметров, совместимого с емкостью обучающего экземпляра EC2, является хорошей практикой и помогает обеспечить плавную настройку модели.