примеры и вычисление функции потерь

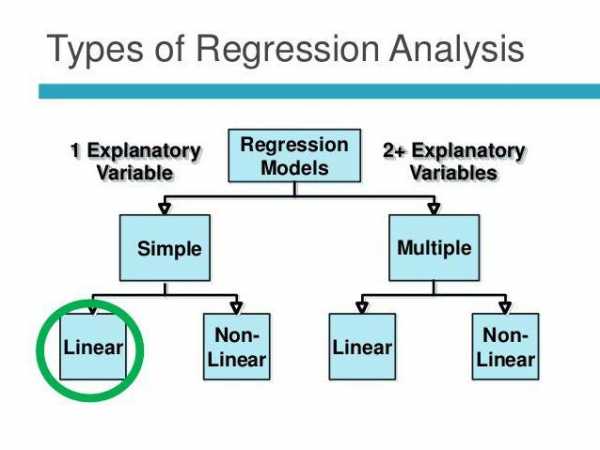

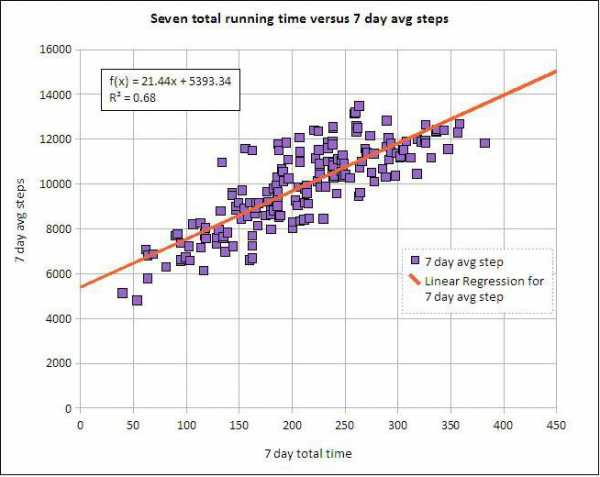

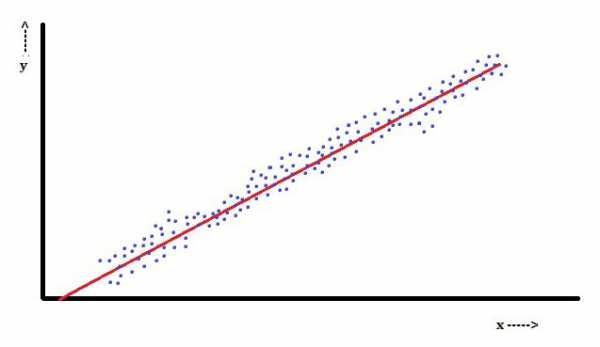

Линейная регрессия (Linear regression) — модель зависимости переменной x от одной или нескольких других переменных (факторов, регрессоров, независимых переменных) с линейной функцией зависимости.

Линейная регрессия относится к задаче определения «линии наилучшего соответствия» через набор точек данных и стала простым предшественником нелинейных методов, которые используют для обучения нейронных сетей. В этой статье покажем вам примеры линейной регрессии.

Применение линейной регрессии

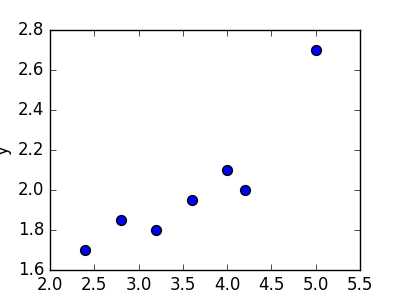

Предположим, нам задан набор из 7 точек (таблица ниже).

Цель линейной регрессии — поиск линии, которая наилучшим образом соответствует этим точкам. Напомним, что общее уравнение для прямой есть f (x) = m⋅x + b, где m — наклон линии, а b — его y-сдвиг. Таким образом, решение линейной регрессии определяет значения для m и b, так что f (x)

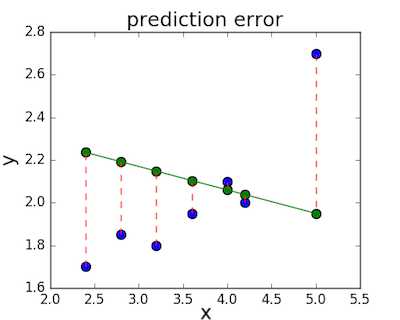

Довольно очевидно, что первые две линии не соответствуют нашим данным. Третья, похоже, лучше, чем две другие. Но как мы можем это проверить? Формально нам нужно выразить, насколько хорошо подходит линия, и мы можем это сделать, определив функцию потерь.

Функция потерь — метод наименьших квадратов

Функция потерь — это мера количества ошибок, которые наша линейная регрессия делает на наборе данных. Хотя есть разные функции потерь, все они вычисляют расстояние между предсказанным значением y(х) и его фактическим значением. Например, взяв строку из среднего примера выше, f(x)=−0.11⋅x+2.5, мы выделяем дистанцию ошибки между фактическими и прогнозируемыми значениями красными пунктирными линиями.

Одна очень распространенная функция потерь называется средней квадратичной ошибкой (MSE). Чтобы вычислить MSE, мы просто берем все значения ошибок, считаем их квадраты длин и усредняем.

Вычислим MSE для каждой из трех функций выше: первая функция дает MSE 0,17, вторая — 0,08, а третья — 0,02. Неудивительно, что третья функция имеет самую низкую MSE, подтверждая нашу догадку, что это линия наилучшего соответствия.

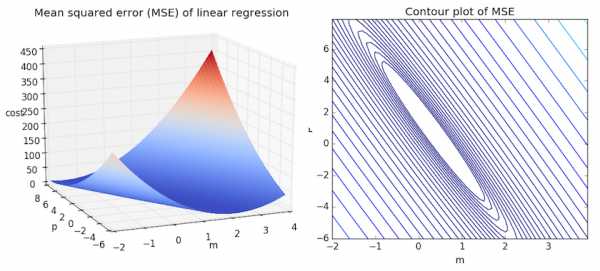

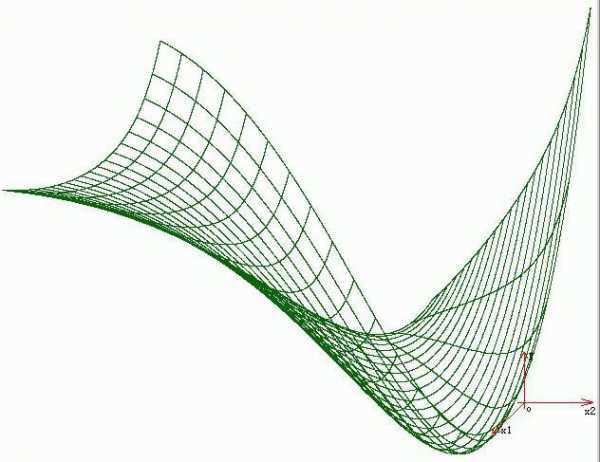

Рассмотрим приведенный ниже рисунок, который использует две визуализации средней квадратичной ошибки в диапазоне, где наклон m находится между -2 и 4, а b между -6 и 8.

Слева: диаграмма, изображающая среднеквадратичную ошибку для -2≤m≤4, -6≤p≤8 Справа: тот же рисунок, но визуализирован как контурный график, где контурные линии являются логарифмически распределенными поперечными сечениями высоты.

Слева: диаграмма, изображающая среднеквадратичную ошибку для -2≤m≤4, -6≤p≤8 Справа: тот же рисунок, но визуализирован как контурный график, где контурные линии являются логарифмически распределенными поперечными сечениями высоты.Глядя на два графика, мы видим, что наш MSE имеет форму удлиненной чаши, которая, по-видимому, сглаживается в овале, грубо центрированном по окрестности

Больше размерностей

Вышеприведенный пример очень простой, он имеет только одну независимую переменную x и два параметра m и b. Что происходит, когда имеется больше переменных? В общем случае, если есть n переменных, их линейная функция может быть записана как:

f(x) = b+w_1*x_1 + … + w_n*x_n

Один трюк, который применяют, чтобы упростить это — думать о нашем смещении «b», как о еще одном весе, который всегда умножается на «фиктивное» входное значение 1. Другими словами:

f(x) = b*1+w_1*x_1 + … + w_n*x_n

Добавление измерений, на первый взгляд, ужасное усложнение проблемы, но оказывается, постановка задачи остается в точности одинаковой в 2, 3 или в любом количестве измерений. Существует функция потерь, которая выглядит как чаша — гипер-чаша! И, как и прежде, наша цель — найти самую нижнюю часть этой чаши, объективно наименьшее значение, которое функция потерь может иметь в отношении выбора параметров и набора данных.

Итак, как мы вычисляем, где именно эта точка на дне? Распространенный подход — обычный метод наименьших квадратов, который решает его аналитически. Когда есть только один или два параметра для решения, это может быть сделано вручную, и его обычно преподают во вводном курсе по статистике или линейной алгебре.

Проклятие нелинейности

Увы, обычный МНК не используют для оптимизации нейронных сетей, поэтому решение линейной регрессии будет оставлено как упражнение, оставленное читателю. Причина, по которой линейную регрессию не используют, заключается в том, что нейронные сети нелинейны.

Различие между линейными уравнениями, которые мы составили, и нейронной сетью — функция активации (например, сигмоида, tanh, ReLU или других).

Эта нелинейность означает, что параметры не действуют независимо друг от друга, влияя на форму функции потерь. Вместо того, чтобы иметь форму чаши, функция потерь нейронной сети более сложна. Она ухабиста и полна холмов и впадин. Свойство быть «чашеобразной» называется выпуклостью, и это ценное свойство в многопараметрической оптимизации. Выпуклая функция потерь гарантирует, что у нас есть глобальный минимум (нижняя часть чаши), и что все дороги под гору ведут к нему.

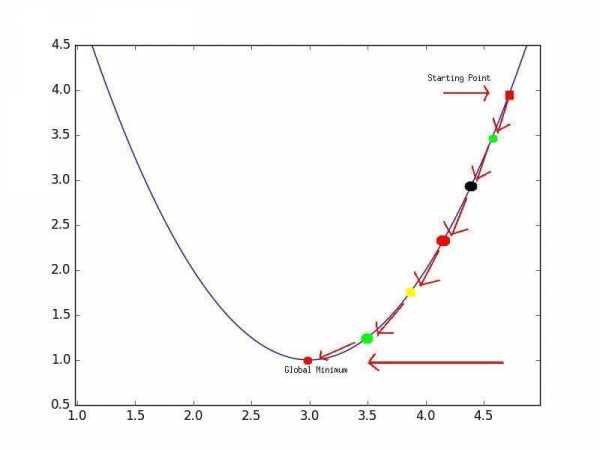

Минимум функции

Минимум функцииНо, вводя нелинейность, мы теряем это удобство ради того, чтобы дать нейронным сетям гораздо большую «гибкость» при моделировании произвольных функций. Цена, которую мы платим, заключается в том, что больше нет простого способа найти минимум за один шаг аналитически. В этом случае мы вынуждены использовать многошаговый численный метод, чтобы прийти к решению. Хотя существует несколько альтернативных подходов, градиентный спуск остается самым популярным методом.

neurohive.io

защитный механизм, примеры регрессии в психологии

Регрессия – это такой способ защиты, когда психика прибегает к возврату в детское состояние с целью понижения тревоги или разрешения конфликта. Соответственно детская модель поведения оказывается незрелой, менее эффективной, затрудняет адаптацию. При этом у окружающих она часто вызывает состояние родителя, бессознательное желание опекать будь-то более слабую или ущербную личность. Однако механизм регрессии включается не лишь в межличностном взаимодействии, человек может активировать его также наедине с собой, во внутренней психологической реальности, ведь детская модель поведения кажется ему более безопасной и успокаивающей.

Что такое регрессия в психологии

Регрессия есть возвращение к своим более ранним формам поведения. Она происходит оттого, что нынешним, зрелым поведением человек не имеет возможности добиться желаемых целей. Например, девушка не может убедить своего мужчину в действительности какого-то факта. Что выбирает она? Часто это слезы, и плач, которые не являются рациональным способом в разрешении ситуации, это тот способ, которым она пользовалась в детстве, дабы привлечь внимание и добиться желаемого.

Спортсмены, занимающиеся боевыми искусствами и изучающие множество приемов в зале, выходя на ринг, используют лишь несколько приемов регрессии, что происходит из-за фрустрации, стресса, в котором человеку свойственно возвращаться к наиболее эффективным ранним формам поведения, которые его никогда не подводили. Хотя их эффективность – очень спорный вопрос, на деле было бы уместнее использовать другие формы поведения. Но есть навыки, какие содержатся в основе психики, как говорят, «на подкорке», вернуться к которым легко, и это происходит бессознательно. Проблему это не решает, но временно успокаивает человека, снижает уровень его тревоги.

Каждый сохраняет из детства воспоминания о приятных моментах, легком разрешении проблем и хоть раз задумывался, чтобы вернуться в детство. Личности же, что используют регрессию как доминирующий механизм защиты, когда она становится стратегией жизни, называются инфантильными, такая длительная регрессия в психологии это синоним инфантилизма.

Регрессия как явление была описана впервые Фрейдом. Регрессия по Фрейду есть отказ от прогрессивного движения желания в сторону действий, возврат к образам или галлюцинациям. Также регрессия по Фрейду находит себя в сновидениях и неврозах, в каких он рассматривал возврат к архаическим формам жизни как индивидуальным, так и филогенетическим.

Регрессия – защитный механизм

Регрессия в психологии это механизм защиты, развивающийся при слабости Я личности, именно к регрессии чаще всего прибегает личность незрелая, поскольку этот способ ей ближе остальных и не требует никаких дополнительных усилий.

В регрессии человек стремится к бессознательному воссоединению, полному комфорту и удовлетворению потребностей, какое он получал от матери. Отсутствие необходимости прилагать усилия, пробуя новые стратегии проведения, при недостатке энергии и инертности личности делает регрессию доступным и простым способом приспособления. Другой вопрос уже, что адаптация затрудняется и в итоге оказывается неполной. Построить зрелые отношения с окружающими при доминирующей регрессивной защите, инфантилизме, становится невозможным. Взаимодействие выстраивается только в случае наличия у партнера дополняющей стратегии, активного состояния родителя, отношения тогда скорее напоминают детско-родительский симбиоз.

Более сильная, стеническая личность прибегает к регрессии, только когда остальные механизмы защиты оказались неэффективными, наступило состояние фрустрации. Регрессия в таком случае чаще всего частичная и непродолжительная, возвратившись к детским формам удовлетворения потребностей и получив желаемую разрядку, снизив напряжение, личность возвращается к другим видам защит. Потому, определив, что регрессия длительное время доминирует в арсенале защит, следует направить внимание на развитие личности, признав ее незрелость. В характере при этом преобладают такие черты, как зависимость от окружающих и их мнения, несамостоятельность, легкая внушаемость и поддавание влиянию других, отсутствие глубоких стабильных интересов, быстрая смена настроений, плаксивость, обидчивость, неумение доводить начатое до конца, безответственность и страх будущего. В крайних случаях это может выразиться в тунеядстве, злоупотреблении алкоголем, зависимости от наркотических препаратов.

Регрессия в психологии – примеры

Частым примером регрессии как отката назад, в прошлое, к более ранним своим паттернам, является поведение старшего ребенка при рождении младшего. Старшему становится тяжело вынести то, что появился еще один объект для родительской любви, и он начинает плакать и капризничать, как несколько лет назад, может начать лезть в коляску, брать одежду, соску и погремушки младшего, есть его еду, гулить, ползать, изображая из себя малыша. Часто даже появляется возврат к непроизвольному мочеиспусканию. Это помогает ему справиться с напряжением, обидой и ревностью, появившимися в связи с конкуренцией, «предательством» родителей, привлечь к себе внимание, чтобы его полюбили так же, как малыша. Более старшему ребенку в данной ситуации кажется, что о нем забыли, хотя в том же возрасте ему уделяли обычно такое же количество внимания.

Регулярные детские болезни также могут говорить о потребности в родительском внимании, при нежелании идти в сад или школу быстро появляются симптомы простуды, а в запущенных ситуациях развиваются и серьезные хронические болезни, имеющие психосоматическую природу. Стоит чаще показывать ребенку свою любовь, а если причина и в плохих отношениях в детском коллективе – поговорить об этом или поменять садик или школу.

То же может происходить и с взрослым человеком, когда он заболевает. Невысокая температура переживается уже как серьезная, тяжелая болезнь, что может бессознательно демонстрироваться окружающим, чтобы получить ту полноту заботы и внимания, какую взрослый помнит из детства. Это то, что в психологии рассматривается как получение вторичной выгоды.

Здесь может иметь место и соматизация, когда и сама болезнь наступает по причине потребности снизить психическое напряжение, словно вернуться в детство и передохнуть. Если действительной причиной болезни была регрессия, то излечение становится очень сложным, усилия докторов часто не приносят нужных результатов, болезнь может менять свои формы или даже переходить в другую, проявляя высокую резистентность к различным врачебным вмешательствам, развивается ипохондрия. Своевременная успешная диагностика психологической причины болезни позволяет не только идти в верном направлении к излечению, но и сохраняет действительное физическое здоровье пациента.

В других случаях уставший взрослый человек может начать хныкать как ребенок, топнуть ногой или обидеться, невесть на кого, развернуться и уйти. Сюда относятся и несдержанность в эмоциях, какую часто прощают детям, бунт против авторитетов, хаотичное поведение, любовь к быстрой и неосторожной езде на машине, не задумываясь о последствиях. В ситуациях перегрузки практически каждый испытывал желание закутаться в одеяло, есть конфеты и смотреть мультики. Некоторые взрослые на всю жизнь сохраняют любовь к детской мультипликации, носят одежду в ребяческом стиле, играют в игры. Компьютерная зависимость также связана с регрессивным уходом от взрослой реальности в детский мир на экране, к которому человек привык еще будучи ребенком.

Примеры регрессии в психологии. Психологи часто наблюдают регрессию у своих клиентов на консультации. Как только психолог с клиентом подходят к сверхважному для последнего вопроса, в котором нужно принять решение – клиент часто не выносит этой эмоциональной перегрузки и начинает дурачиться: накручивать волосы на нос, снимать и играть кольцом, крутиться на кресле, шутить. Регресс в детское поведение оттаскивает человека назад, чтобы снизить критический уровень напряжения, и психолог должен отследить это и проработать с клиентом.

Регрессивный откат в детство свойственен практически всем людям в ситуации, когда желаемое можно получить от кого-то из близких. Так ребенок начинает выпрашивать конфеты у матери более детским голосом, капризничая и давя на жалость. Также может поступать и жена, прося у мужа, например, купить ей платье, бессознательно активируя в себе поведение маленькой девочки. А муж может проситься на рыбалку с друзьями, обещая свое хорошее поведение, словно мальчишка.

Склонность к мистике часто также является регрессивной защитой, когда человек не желает разбираться в реальных причинах происходящего, что потребует от него усилий и ответственности в разрешении проблемы, а, к примеру, оправдывает сложности наложенной порчей или родовым проклятием.

Регрессивность часто находит выражение в откате к более ранним психосексуальным формам развития, что связано с возникновением неврозов. В случае регрессии либидо в полном объеме генитальность замещается прегенитальными способами проявления сексуальности, откуда развивается анально-садистичные или инцестуозные наклонности, бисексуальность, нарциссизм.

К механизмам регрессии часто прибегают маркетологи, создавая в рекламе предпосылки для эмоционального возвращения в детские ощущения полного комфорта, тотальной продуманности и контроля производителем своего продукта, приобретя который человек может, словно погрузиться в идеальную реальность.

psihomed.com

Основы регрессионного анализа—Справка | ArcGIS Desktop

Набор инструментов Пространственная статистика (Spatial Statistics) предоставляет эффективные инструменты количественного анализа пространственных структурных закономерностей. Инструмент Анализ горячих точек (Hot Spot Analysis), например, поможет найти ответы на следующие вопросы:

- Есть ли в США места, где постоянно наблюдается высокая смертность среди молодежи?

- Где находятся «горячие точки» по местам преступлений, вызовов 911 (см. рисунок ниже) или пожаров?

- Где находятся места, в которых количество дорожных происшествий превышает обычный городской уровень?

Анализ данных звонков в службу 911, показывающий горячие точки (красным), холодные точки (синим) и локализацию пожарных/полиции, ответственных за реагирование (зеленые круги)

Каждый из вопросов спрашивает «где»? Следующий логический вопрос для такого типа анализа – «почему»?

- Почему в некоторых местах США наблюдается повышенная смертность молодежи? Какова причина этого?

- Можем ли мы промоделировать характеристики мест, на которые приходится больше всего преступлений, звонков в 911, или пожаров, чтобы помочь сократить эти случаи?

- От каких факторов зависит повышенное число дорожных происшествий? Имеются ли какие-либо возможности для снижения числа дорожных происшествий в городе вообще, и в особо неблагополучных районах в частности?

Инструменты в наборе инструментов Моделирование пространственных отношений помогут вам ответить на вторую серию вопросов «почему». К этим инструментам относятся Метод наименьших квадратов и Географически взвешенная регрессия.

Пространственные отношения

Регрессионный анализ позволяет вам моделировать, проверять и исследовать пространственные отношения и помогает вам объяснить факторы, стоящие за наблюдаемыми пространственными структурными закономерностями. Вы также можете захотеть понять, почему люди постоянно умирают молодыми в некоторых регионах страны, и какие факторы особенно влияют на особенно высокий уровень диабета. При моделирование пространственных отношений, однако, регрессионный анализ также может быть пригоден для прогнозирования. Моделирование факторов, которые влияют на долю выпускников колледжей, на пример, позволяют вам сделать прогноз о потенциальной рабочей силе и их навыках. Вы также можете использовать регрессионный анализ для прогнозирования осадков или качества воздуха в случаях, где интерполяция невозможна из-за малого количества станций наблюдения (к примеру, часто отсутствую измерительные приборы вдоль горных хребтов и в долинах).

МНК (OLS) – наиболее известный метод регрессионного анализа. Это также подходящая отправная точка для всех способов пространственного регрессионного анализа. Данный метод позволяет построить глобальную модель переменной или процесса, которые вы хотите изучить или спрогнозировать (уровень смертности/осадки). Он создает уравнение регрессии, отражающее происходящий процесс. Географически взвешенная регрессия (ГВР) – один из нескольких методов пространственного регрессионного анализа, все чаще использующегося в географии и других дисциплинах. Метод ГВР (географически взвешенная регрессия) создает локальную модель переменной или процесса, которые вы прогнозируете или изучаете, применяя уравнение регрессии к каждому пространственному объекту в наборе данных. При подходящем использовании, эти методы являются мощным и надежным статистическим средством для проверки и оценки линейных взаимосвязей.

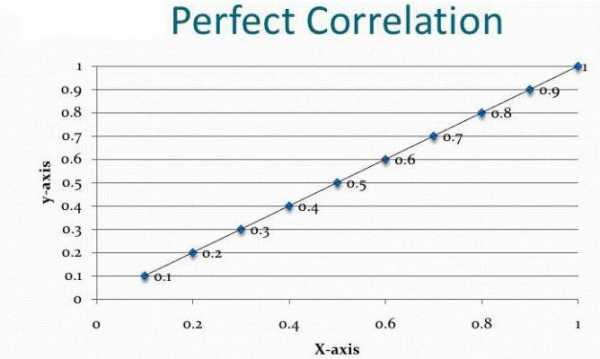

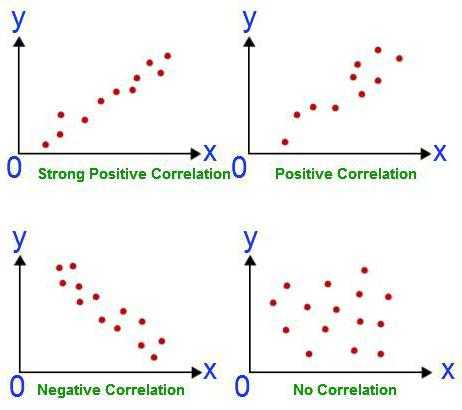

Линейные взаимосвязи могут быть положительными или отрицательными. Если вы обнаружили, что количество поисково-спасательных операций увеличивается при возрастании среднесуточной температуры, такое отношение является положительным; имеется положительная корреляция. Другой способ описать эту положительную взаимосвязь – сказать, что количество поисково-спасательных операций уменьшается при уменьшении среднесуточной температуры. Соответственно, если вы установили, что число преступлений уменьшается при увеличении числа полицейских патрулей, данное отношение является отрицательным. Также, можно выразить это отрицательное отношение, сказав, что количество преступлений увеличивается при уменьшении количества патрулей. На рисунке ниже показаны положительные и отрицательные отношения, а также случаи, когда две переменные не связаны отношениями:

Диаграммы рассеивания: положительная связь, отрицательная связь и пример с 2 не связанными переменными.Корреляционные анализы, и связанные с ними графики, отображенные выше, показывают силу взаимосвязи между двумя переменными. С другой стороны, регрессионные анализы дают больше информации: они пытаются продемонстрировать степень, с которой 1 или более переменных потенциально вызывают положительные или негативные изменения в другой переменной.

Применения регрессионного анализа

Регрессионный анализ может использоваться в большом количестве приложений:

- Моделирование числа поступивших в среднюю школу для лучшего понимания факторов, удерживающих детей в том же учебном заведении.

- Моделирование дорожных аварий как функции скорости, дорожных условий, погоды и т.д., чтобы проинформировать полицию и снизить несчастные случаи.

- Моделирование потерь от пожаров как функции от таких переменных как степень вовлеченности пожарных департаментов, время обработки вызова, или цена собственности. Если вы обнаружили, что время реагирования на вызов является ключевым фактором, возможно, существует необходимость создания новых пожарных станций. Если вы обнаружили, что вовлеченность – главный фактор, возможно, вам нужно увеличить оборудование и количество пожарных, отправляемых на пожар.

Существует три первостепенных причины, по которым обычно используют регрессионный анализ:

- Смоделировать некоторые явления, чтобы лучше понять их и, возможно, использовать это понимание для оказания влияния на политику и принятие решений о наиболее подходящих действиях. Основная цель – измерить экстент, который при изменениях в одной или более переменных связанно вызывает изменения и в другой. Пример. Требуется понять ключевые характеристики ареала обитания некоторых видов птиц (например, осадки, ресурсы питания, растительность, хищники) для разработки законодательства, направленного на защиту этих видов.

- Смоделировать некоторые явления, чтобы предсказать значения в других местах или в другое время. Основная цель – построить прогнозную модель, которая является как устойчивой, так и точной. Пример: Даны прогнозы населения и типичные погодные условия. Каким будет объем потребляемой электроэнергии в следующем году?

- Вы также можете использовать регрессионный анализ для исследования гипотез. Предположим, что вы моделируете бытовые преступления для их лучшего понимания и возможно, вам удается внедрить политические меры, чтобы остановить их. Как только вы начинаете ваш анализ, вы, возможно, имеете вопросы или гипотезы, которые вы хотите проверить:

- «Теория разбитого окна» указывает на то, что испорченная общественная собственность (граффити, разрушенные объекты и т.д.) притягивает иные преступления. Имеется ли положительное отношение между вандализмом и взломами в квартиры?

- Имеется ли связь между нелегальным использованием наркотических средств и взломами в квартиры (могут ли наркоманы воровать, чтобы поддерживать свое существование)?

- Совершаются ли взломы с целью ограбления? Возможно ли, что будет больше случаев в домохозяйствах с большей долей пожилых людей и женщин?

- Люди больше подвержены риску ограбления, если они живут в богатой или бедной местности?

Термины и концепции регрессионного анализа

Невозможно обсуждать регрессионный анализ без предварительного знакомства с основными терминами и концепциями, характерными для регрессионной статистики:

Уравнение регрессии. Это математическая формула, применяемая к независимым переменным, чтобы лучше спрогнозировать зависимую переменную, которую необходимо смоделировать. К сожалению, для тех ученых, кто думает, что х и у это только координаты, независимая переменная в регрессионном анализе всегда обозначается как y, а зависимая – всегда X. Каждая независимая переменная связана с коэффициентами регрессии, описывающими силу и знак взаимосвязи между этими двумя переменными. Уравнение регрессии может выглядеть следующим образом (у – зависимая переменная, Х – независимые переменные, β – коэффициенты регрессии), ниже приводится описание каждого из этих компонентов уравнения регрессии):

Элементы Уравнения регрессии по методу наименьших квадратов- Зависимая переменная (y) – это переменная, описывающая процесс, который вы пытаетесь предсказать или понять (бытовые кражи, осадки). В уравнении регрессии эта переменная всегда находится слева от знака равенства. В то время, как можно использовать регрессию для предсказания зависимой величины, вы всегда начинаете с набора хорошо известных у-значений и используете их для калибровки регрессионной модели. Известные у-значения часто называют наблюдаемыми величинами.

- Независимые переменные (X) это переменные, используемые для моделирования или прогнозирования значений зависимых переменных. В уравнении регрессии они располагаются справа от знака равенства и часто называются независимыми переменными. Зависимая переменная – это функция независимых переменных. Если вас интересует прогнозирование годового оборота определенного магазина, можно включить в модель независимые переменные, отражающие, например, число потенциальных покупателей, расстояние до конкурирующих магазинов, заметность магазина и структуру спроса местных жителей.

- Коэффициенты регрессии (β) – это коэффициенты, которые рассчитываются в результате выполнения регрессионного анализа. Вычисляются величины для каждой независимой переменной, которые представляют силу и тип взаимосвязи независимой переменной по отношению к зависимой. Предположим, что вы моделируете частоту пожаров как функцию от солнечной радиации, растительного покрова, осадков и экспозиции склона. Вы можете ожидать положительную взаимосвязь между частотой пожаров и солнечной радиацией (другими словами, чем больше солнца, тем чаще встречаются пожары). Если отношение положительно, знак связанного коэффициента также положителен. Вы можете ожидать негативную связь между частотой пожаров и осадками (другими словами, для мест с большим количеством осадков характерно меньше лесных пожаров). Коэффициенты отрицательных отношений имеют знак минуса. Когда взаимосвязь сильная, значения коэффициентов достаточно большие (относительно единиц независимой переменной, с которой они связаны). Слабая взаимосвязь описывается коэффициентами с величинами около 0; β0 – это пересечение линии регрессии. Он представляет ожидаемое значение зависимой величины, если все независимые переменные равны 0.

P-значения. Большинство регрессионных методов выполняют статистический тест для расчета вероятности, называемой р-значением, для коэффициентов, связанной с каждой независимой переменной. Нулевая гипотеза данного статистического теста предполагает, что коэффициент незначительно отличается от нуля (другими словами, для всех целей и задач, коэффициент равен нулю, и связанная независимая переменная не может объяснить вашу модель). Маленькие величины р-значений отражают маленькие вероятности и предполагают, что коэффициент действительно важен для вашей модели со значением, существенно отличающимся от 0 (другими словами, маленькие величины р-значений свидетельствуют о том, что коэффициент не равен 0). Вы бы сказали, что коэффициент с р-значением, равным 0,01, например, статистически значимый для 99 % доверительного интервала; связанные переменные являются эффективным предсказателем. Переменные с коэффициентами около 0 не помогают предсказать или смоделировать зависимые величины; они практически всегда удаляются из регрессионного уравнения, если только нет веских причин сохранить их.

R2/R-квадрат: Статистические показатели составной R-квадрат и выровненный R-квадрат вычисляются из регрессионного уравнения, чтобы качественно оценить модель. Значение R-квадрат лежит в пределах от 0 до 100 процентов. Если ваша модель описывает наблюдаемые зависимые переменные идеально, R-квадрат равен 1.0 (и вы, несомненно, сделали ошибку; возможно, вы использовали модификацию величины у для предсказания у). Вероятнее всего, вы увидите значения R-квадрат в районе 0,49, например, можно интерпретировать подобный результат как «Это модель объясняет 49 % вариации зависимой величины». Чтобы понять, как работает R-квадрат, постройте график, отражающий наблюдаемые и оцениваемые значения у, отсортированные по оцениваемым величинам. Обратите внимание на количество совпадений. Этот график визуально отображает, насколько хорошо вычисленные значения модели объясняют изменения наблюдаемых значений зависимых переменных. Просмотрите иллюстрацию. Выверенный R-квадрат всегда немного меньше, чем составной R-квадрат, т.к. он отражает всю сложность модели (количество переменных) и связан с набором исходных данных. Следовательно, выверенный R-квадрат является более точной мерой для оценки результатов работы модели.

Невязки. Существует необъяснимое количество зависимых величин, представленных в уравнении регрессии как случайные ошибки ε. Просмотрите иллюстрацию. Известные значения зависимой переменной используются для построения и настройки модели регрессии. Используя известные величины зависимой переменной (Y) и известные значений для всех независимых переменных (Хs), регрессионный инструмент создаст уравнение, которое предскажет те известные у-значения как можно лучше. Однако предсказанные значения редко точно совпадают с наблюдаемыми величинами. Разница между наблюдаемыми и предсказываемыми значениями у называется невязка или отклонение. Величина отклонений регрессионного уравнения – одно из измерений качества работы модели. Большие отклонения говорят о ненадлежащем качестве модели.

Создание регрессионной модели представляет собой итерационный процесс, направленный на поиск эффективных независимых переменных, чтобы объяснить зависимые переменные, которые вы пытаетесь смоделировать или понять, запуская инструмент регрессии, чтобы определить, какие величины являются эффективными предсказателями. Затем пошаговое удаление и/или добавление переменных до тех пор, пока вы не найдете наилучшим образом подходящую регрессионную модель. Т.к. процесс создания модели часто исследовательский, он никогда не должен становиться простым «подгоном» данных. Он должен учитывать теоретические аспекты, мнение экспертов в этой области и здравый смысл. Вы должным быть способны определить ожидаемую взаимосвязь между каждой потенциальной независимой переменной и зависимой величиной до непосредственного анализа, и должны задать себе дополнительные вопросы, когда эти связи не совпадают.

Примечание:

Если вы никогда не выполняли регрессионный анализ раньше, рекомендуем загрузить Руководство о регрессионному анализу и пройти шаги 1-5.

Особенности регрессионного анализа

Регрессия МНК (OLS) – это простой метод анализа с хорошо проработанной теорией, предоставляющий эффективные возможности диагностики, которые помогут вам интерпретировать результаты и устранять неполадки. Однако, МНК надежен и эффективен, если ваши данные и регрессионная модель удовлетворяют всем предположениям, требуемым для этого метода (смотри таблицу внизу). Пространственные данные часто нарушают предположения и требования МНК, поэтому важно использовать инструменты регрессии в союзе с подходящими инструментами диагностики, которые позволяют оценить, является ли регрессия подходящим методом для вашего анализа, а приведенная структура данных и модель может быть применена.

Как регрессионная модель может не работать

Серьезной преградой для многих регрессионных моделей является ошибка спецификации. Модель ошибки спецификации – это такая неполная модель, в которой отсутствуют важные независимые переменные, поэтому она неадекватно представляет то, что мы пытаемся моделировать или предсказывать (зависимую величину, у). Другими словами, регрессионная модель не рассказывает вам всю историю. Ошибка спецификации становится очевидной, когда в отклонениях вашей регрессионной модели наблюдается статистически значимая пространственная автокорреляция, или другими словами, когда отклонения вашей модели кластеризуются в пространстве (недооценки – в одной области изучаемой территории, а переоценки – в другой). Благодаря картографированию невязок регрессии или коэффициентов, связанных с географически взвешенной регрессией, можно обратить внимание на какие-то нюансы, которые вы упустили ранее. Запуск Анализа горячих точек по отклонениям регрессии также может раскрыть разные пространственные режимы, которые можно моделировать при помощи метода наименьших квадратов с региональными показателями или исправлять с использованием географически взвешенной регрессии. Предположим, когда вы картографируете отклонения вашей регрессионной модели, вы видите, что модель всегда заново предсказывает значения в горах, и, наоборот, в долинах, что может значить, что отсутствуют данные о рельефе. Однако может случиться так, что отсутствующие переменные слишком сложны для моделирования или их невозможно подсчитать или слишком трудно измерить. В этих случаях, можно воспользоваться ГВР (географически взвешенной регрессией) или другой пространственной регрессией, чтобы получить хорошую модель.

В следующей таблице перечислены типичные проблемы с регрессионными моделями и инструменты в ArcGIS:

Типичные проблемы с регрессией, последствия и решения

Ошибки спецификации относительно независимых переменных. | Когда ключевые независимые переменные отсутствуют в регрессионном анализе, коэффициентам и связанным с ними р-значениям нельзя доверять. | Создайте карту и проверьте невязки МНК и коэффициенты ГВР или запустите Анализ горячих точек по регрессионным невязкам МНК, чтобы увидеть, насколько это позволяет судить о возможных отсутствующих переменных. |

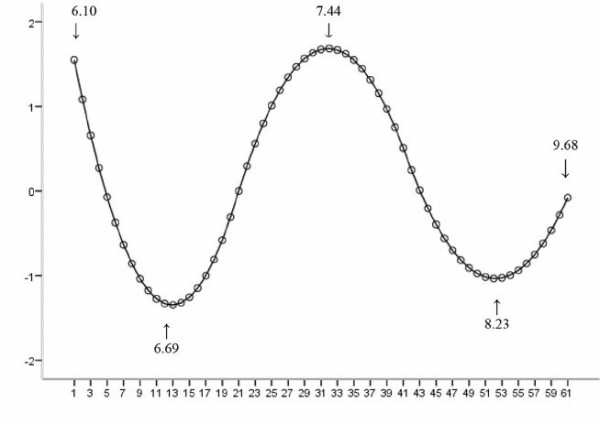

Нелинейные взаимосвязи. Просмотрите иллюстрацию. | МНК и ГВР – линейные методы. Если взаимосвязи между любыми независимыми величинами и зависимыми – нелинейны, результирующая модель будет работать плохо. | Создайте диаграмму рассеяния, чтобы выявить взаимосвязи между показателями в модели. Уделите особое внимание взаимосвязям, включающим зависимые переменные. Обычно криволинейность может быть устранена трансформированием величин. Просмотрите иллюстрацию. Альтернативно, используйте нелинейный метод регрессии. |

Выбросы данных. Просмотрите иллюстрацию. | Существенные выбросы могут увести результаты взаимоотношений регрессионной модели далеко от реальности, внося ошибку в коэффициенты регрессии. | Создайте диаграмму рассеяния и другие графики (гистограммы), чтобы проверить экстремальные значения данных. Скорректировать или удалить выбросы, если они представляют ошибки. Когда выбросы соответствуют действительности, |

desktop.arcgis.com

Пример решения задачи множественной регрессии с помощью Python / Habr

Введение

Добрый день, уважаемые читатели.

В прошлых статьях, на практических примерах, мной были показаны способы решения задач классификации (задача кредитного скоринга) и основ анализа текстовой информации (задача о паспортах). Сегодня же мне бы хотелось коснуться другого класса задач, а именно восстановления регрессии. Задачи данного класса, как правило, используются при прогнозировании.

Для примера решения задачи прогнозирования, я взял набор данных Energy efficiency из крупнейшего репозитория UCI. В качестве инструментов по традиции будем использовать Python c аналитическими пакетами pandas и scikit-learn.

Описание набора данных и постановка задачи

Дан набор данных, котором описаны следующие атрибуты помещения:

| Поле | Описание | Тип |

|---|---|---|

| X1 | Относительная компактность | FLOAT |

| X2 | Площадь | FLOAT |

| X3 | Площадь стены | FLOAT |

| X4 | Площадь потолка | FLOAT |

| X5 | Общая высота | FLOAT |

| X6 | Ориентация | INT |

| X7 | Площадь остекления | FLOAT |

| X8 | Распределенная площадь остекления | INT |

| y1 | Нагрузка при обогреве | FLOAT |

| y2 | Нагрузка при охлаждении | FLOAT |

В нем — характеристики помещения на основании которых будет проводиться анализ, а — значения нагрузки, которые надо спрогнозировать.

Предварительный анализ данных

Для начала загрузим наши данные и посмотрим на них:

from pandas import read_csv, DataFrame

from sklearn.neighbors import KNeighborsRegressor

from sklearn.linear_model import LinearRegression, LogisticRegression

from sklearn.svm import SVR

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import r2_score

from sklearn.cross_validation import train_test_split

dataset = read_csv('EnergyEfficiency/ENB2012_data.csv',';')

dataset.head()

| X1 | X2 | X3 | X4 | X5 | X6 | X7 | X8 | Y1 | Y2 | |

|---|---|---|---|---|---|---|---|---|---|---|

| 0 | 0.98 | 514.5 | 294.0 | 110.25 | 7 | 2 | 0 | 0 | 15.55 | 21.33 |

| 1 | 0.98 | 514.5 | 294.0 | 110.25 | 7 | 3 | 0 | 0 | 15.55 | 21.33 |

| 2 | 0.98 | 514.5 | 294.0 | 110.25 | 7 | 4 | 0 | 0 | 15.55 | 21.33 |

| 3 | 0.98 | 514.5 | 294.0 | 110.25 | 7 | 5 | 0 | 0 | 15.55 | 21.33 |

| 4 | 0.90 | 563.5 | 318.5 | 122.50 | 7 | 2 | 0 | 0 | 20.84 | 28.28 |

Теперь давайте посмотрим не связаны ли между собой какие-либо атрибуты. Сделать это можно рассчитав коэффициенты корреляции для всех столбцов. Как это сделать было описано в предыдущей статье:

dataset.corr()

| X1 | X2 | X3 | X4 | X5 | X6 | X7 | X8 | Y1 | Y2 | |

|---|---|---|---|---|---|---|---|---|---|---|

| X1 | 1.000000e+00 | -9.919015e-01 | -2.037817e-01 | -8.688234e-01 | 8.277473e-01 | 0.000000 | 1.283986e-17 | 1.764620e-17 | 0.622272 | 0.634339 |

| X2 | -9.919015e-01 | 1.000000e+00 | 1.955016e-01 | 8.807195e-01 | -8.581477e-01 | 0.000000 | 1.318356e-16 | -3.558613e-16 | -0.658120 | -0.672999 |

| X3 | -2.037817e-01 | 1.955016e-01 | 1.000000e+00 | -2.923165e-01 | 2.809757e-01 | 0.000000 | -7.969726e-19 | 0.000000e+00 | 0.455671 | 0.427117 |

| X4 | -8.688234e-01 | 8.807195e-01 | -2.923165e-01 | 1.000000e+00 | -9.725122e-01 | 0.000000 | -1.381805e-16 | -1.079129e-16 | -0.861828 | -0.862547 |

| X5 | 8.277473e-01 | -8.581477e-01 | 2.809757e-01 | -9.725122e-01 | 1.000000e+00 | 0.000000 | 1.861418e-18 | 0.000000e+00 | 0.889431 | 0.895785 |

| X6 | 0.000000e+00 | 0.000000e+00 | 0.000000e+00 | 0.000000e+00 | 0.000000e+00 | 1.000000 | 0.000000e+00 | 0.000000e+00 | -0.002587 | 0.014290 |

| X7 | 1.283986e-17 | 1.318356e-16 | -7.969726e-19 | -1.381805e-16 | 1.861418e-18 | 0.000000 | 1.000000e+00 | 2.129642e-01 | 0.269841 | 0.207505 |

| X8 | 1.764620e-17 | -3.558613e-16 | 0.000000e+00 | -1.079129e-16 | 0.000000e+00 | 0.000000 | 2.129642e-01 | 1.000000e+00 | 0.087368 | 0.050525 |

| Y1 | 6.222722e-01 | -6.581202e-01 | 4.556712e-01 | -8.618283e-01 | 8.894307e-01 | -0.002587 | 2.698410e-01 | 8.736759e-02 | 1.000000 | 0.975862 |

| Y2 | 6.343391e-01 | -6.729989e-01 | 4.271170e-01 | -8.625466e-01 | 8.957852e-01 | 0.014290 | 2.075050e-01 | 5.052512e-02 | 0.975862 | 1.000000 |

Как можно заметить из нашей матрицы, коррелируют между собой следующие столбы (Значение коэффициента корреляции больше 95%):

- y1 —> y2

- x1 —> x2

- x4 —> x5

Теперь давайте выберем, какие столбцы их наших пар мы можем убрать из нашей выборки. Для этого, в каждой паре, выберем столбцы, которые в большей степени оказывают влияние на прогнозные значения Y1 и Y2 и оставим их, а остальные удалим.

Как можно заметить и матрицы с коэффициентами корреляции на y1,y2 больше значения оказывают X2 и X5, нежели X1 и X4, таким образом мы можем последние столбцы мы можем удалить.

dataset = dataset.drop(['X1','X4'], axis=1)

dataset.head()

Помимо этого, можно заметить, что поля Y1 и Y2 очень тесно коррелируют между собой. Но, т. к. нам надо спрогнозировать оба значения мы их оставляем «как есть».

Выбор модели

Отделим от нашей выборки прогнозные значения:

trg = dataset[['Y1','Y2']]

trn = dataset.drop(['Y1','Y2'], axis=1)

После обработки данных можно перейти к построению модели. Для построения модели будем использовать следующие методы:

Теорию о данным методам можно почитать в курсе лекций К.В.Воронцова по машинному обучению.

Оценку будем производить с помощью коэффициента детерминации (R-квадрат). Данный коэффициент определяется следующим образом:

, где — условная дисперсия зависимой величины у по фактору х.

Коэффициент принимает значение на промежутке и чем он ближе к 1 тем сильнее зависимость.

Ну что же теперь можно перейти непосредственно к построению модели и выбору модели. Давайте поместим все наши модели в один список для удобства дальнейшего анализа:

models = [LinearRegression(), # метод наименьших квадратов

RandomForestRegressor(n_estimators=100, max_features ='sqrt'), # случайный лес

KNeighborsRegressor(n_neighbors=6), # метод ближайших соседей

SVR(kernel='linear'), # метод опорных векторов с линейным ядром

LogisticRegression() # логистическая регрессия

]

Итак модели готовы, теперь мы разобьем наши исходные данные на 2 подвыборки: тестовую и обучающую. Кто читал мои предыдущие статьи знает, что сделать это можно с помощью функции train_test_split() из пакета scikit-learn:

Xtrn, Xtest, Ytrn, Ytest = train_test_split(trn, trg, test_size=0.4)

Теперь, т. к. нам надо спрогнозировать 2 параметра , надо построить регрессию для каждого из них. Кроме этого, для дальнейшего анализа, можно записать полученные результаты во временный DataFrame. Сделать это можно так:

#создаем временные структуры

TestModels = DataFrame()

tmp = {}

#для каждой модели из списка

for model in models:

#получаем имя модели

m = str(model)

tmp['Model'] = m[:m.index('(')]

#для каждого столбцам результирующего набора

for i in xrange(Ytrn.shape[1]):

#обучаем модель

model.fit(Xtrn, Ytrn[:,i])

#вычисляем коэффициент детерминации

tmp['R2_Y%s'%str(i+1)] = r2_score(Ytest[:,0], model.predict(Xtest))

#записываем данные и итоговый DataFrame

TestModels = TestModels.append([tmp])

#делаем индекс по названию модели

TestModels.set_index('Model', inplace=True)

Как можно заметить из кода выше, для расчета коэффициента используется функция r2_score().

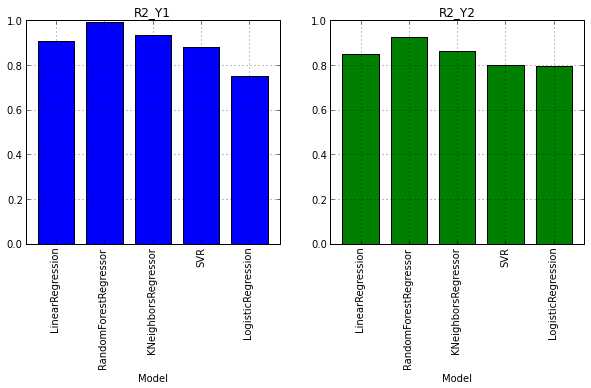

Итак, данные для анализа получены. Давайте теперь построим графики и посмотрим какая модель показала лучший результат:

fig, axes = plt.subplots(ncols=2, figsize=(10,4))

TestModels.R2_Y1.plot(ax=axes[0], kind='bar', title='R2_Y1')

TestModels.R2_Y2.plot(ax=axes[1], kind='bar', color='green', title='R2_Y2')

Анализ результатов и выводы

Из графиков, приведенных выше, можно сделать вывод, что лучше других с задачей справился метод RandomForest (случайный лес). Его коэффициенты детерминации выше остальных по обоим переменным:

ля дальнейшего анализа давайте заново обучим нашу модель:

model = models[1]

model.fit(Xtrn, Ytrn)

При внимательном рассмотрении, может возникнуть вопрос, почему в предыдущий раз и делили зависимую выборку Ytrn на переменные(по столбцам), а теперь мы этого не делаем.

Дело в том, что некоторые методы, такие как RandomForestRegressor, может работать с несколькими прогнозируемыми переменными, а другие (например SVR) могут работать только с одной переменной. Поэтому на при предыдущем обучении мы использовали разбиение по столбцам, чтобы избежать ошибки в процессе построения некоторых моделей.

Выбрать модель это, конечно же, хорошо, но еще неплохо бы обладать информацией, как каждый фактор влиет на прогнозное значение. Для этого у модели есть свойство feature_importances_.

С помощью него, можно посмотреть вес каждого фактора в итоговой моделей:

model.feature_importances_

array([ 0.40717901, 0.11394948, 0.34984766, 0.00751686, 0.09158358,

0.02992342])

В нашем случае видно, что больше всего на нагрузку при обогреве и охлаждении влияют общая высота и площадь. Их общий вклад в прогнозной модели около 72%.

Также необходимо отметить, что по вышеуказанной схеме можно посмотреть влияние каждого фактора отдельно на обогрев и отдельно на охлаждение, но т. к. эти факторы у нас очень тесно коррелируют между собой (), мы сделали общий вывод по ним обоим который и был написан выше.

Заключение

В статье я постарался показать основные этапы при регрессионном анализе данных с помощью Python и аналитческих пакетов pandas и scikit-learn.

Необходимо отметить, что набор данных специально выбирался таким образом чтобы быть максимально формализованым и первичная обработка входных данных была бы минимальна. На мой взгляд статья будет полезна тем, кто только начинает свой путь в анализе данных, а также тем кто имеет хорошую теоретическую базу, но выбирает инструментарий для работы.

habr.com

Парная линейная регрессия. Задачи регрессионного анализа

Линейная регрессия — выраженная в виде прямой зависимость среднего значения какой-либо величины от некоторой другой величины. В отличие от функциональной зависимости y = f(x), когда каждому значению независимой переменной x соответствует одно определённое значение величины y, при линейной регрессии одному и тому же значению x могут соответствовать в зависимости от случая различные значения величины y.

Если в результате наблюдения установлено, что при каждом определённом значении x существует сколько-то (n) значений переменной y, то зависимость средних арифметических значений y от x и является регрессией в статистическом понимании.

Если установленная зависимость может быть записана в виде уравнения прямой

y = ax + b,

то эта регрессионная зависимость называется линейной регрессией.

О парной линейной регрессии говорят, когда установлена зависимость между двумя переменными величинами (x и y). Парная линейная регрессия называется также однофакторной линейной регрессией, так как один фактор (независимая переменная x) влияет на результирующую переменную (зависимую переменную y).

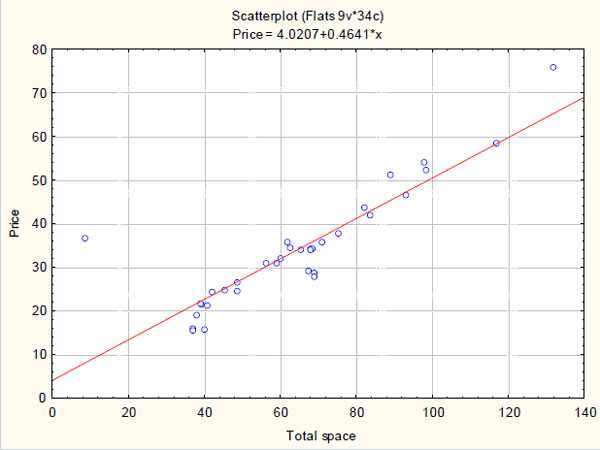

В уроке о корреляционной зависимости были разобраны примеры того, как цена на квартиры зависит от общей площади квартиры и от площади кухни (две различные независимые переменные) и о том, что результаты наблюдений расположены в некотором приближении к прямой, хотя и не на самой прямой. Если точки корреляционной диаграммы соединить ломанной линией, то будет получена линия эмпирической регрессии. А если эта линия будет выровнена в прямую, то полученная прямая будет прямой теоретической регрессии. На рисунке ниже она красного цвета (для увеличения рисунка щёлкнуть по нему левой кнопкой мыши).

По этой прямой теоретической регрессии может быть сделан прогноз или восстановление неизвестных значений зависимой переменной по заданным значениям независимой переменной.

В случае парной линейной регрессии для данных генеральной совокупности связь между независимой переменной (факториальным признаком) X и зависимой переменной (результативным признаком) Y описывает модель

,

где

— свободный член прямой парной линейной регрессии,

— коэффициент направления прямой парной линейной регрессии,

— случайная погрешность,

N — число элементов генеральной совокупности.

Уравнение парной линейной регрессии для генеральной совокупности можно построить, если доступны данные обо всех элементах генеральной совокупности. На практике данные всей генеральной совокупности недоступны, но доступны данные об элементах некоторой выборки.

Поэтому параметры генеральной совокупности оценивают при помощи соответствующих параметров соответствующей выборки: свободный член прямой парной линейной регрессии генеральной совокупности заменяют на свободный член прямой парной линейной регрессии выборки , а коэффициент направления прямой парной линейной регрессии генеральной совокупности — на коэффициент направления прямой парной линейной регрессии выборки .

В результате получаем уравнение парной линейной регрессии выборки

или

где

— оценка полученной с помощью модели линейной регрессии зависимой переменной Y,

— погрешность,

n — размер выборки.

Чтобы уравнение парной линейной регрессии было более похоже на привычное уравнение прямой, его часто также записывают в виде

.

Определение коэффициентов уравнения парной линейной регрессии

Если заранее известно, что зависимость между факториальным признаком x и результативным признаком y должна быть линейной, выражающейся в виде уравнения типа , задача сводится к нахождению по некоторой группе точек наилучшей прямой, называемой прямой парной линейной регрессии. Следует найти такие значения коэффициентов a и b , чтобы сумма квадратов отклонений была наименьшей:

.

Если через и обозначить средние значения признаков X и Y,то полученная с помощью метода наименьших квадратов функция регрессии удовлетворяет следующим условиям:

Условие метода наименьших квадратов выполняется, если значения коэффициентов равны:

,

.

Пример 1. Найти уравнение парной линейной регрессии зависимости между валовым внутренним продуктом (ВВП) и частным потреблением на основе данных примера урока о корреляционной зависимости (эта ссылка, которая откроется в новом окне, потребуется и при разборе следующих примеров).

Решение. Используем рассчитанные в решении названного выше примера суммы:

Используя эти суммы, вычислим коэффициенты:

Таким образом получили уравнение прямой парной линейной регрессии:

Составить уравнение парной линейной регрессии самостоятельно, а затем посмотреть решение

Пример 2. Найти уравнение парной линейной регрессии для выборки из 6 наблюдений, если уже вычислены следующие промежуточные результаты:

;

;

;

;

Правильное решение и ответ.

Метод наименьших квадратов имеет по меньшей мере один существенный недостаток: с его помощью можно найти уравнение линейной регрессии и в тех случаях, когда данные наблюдений значительно рассеяны вокруг прямой регрессии, то есть находятся на значительном расстоянии от этой прямой. В таких случаях за точность прогноза значений зависимой переменной ручаться нельзя. Существуют показатели, которые позволяют оценить качество уравнения линейной регрессии прежде чем использовать модели линейной регрессии для практических целей. Разберём важнейшие из этих показателей.

Коэффициент детерминации

Коэффициент детерминации принимает значения от 0 до 1 и в случае качественной модели линейной регрессии стремится к единице. Коэффициент детерминации показывает, какую часть общего рассеяния зависимой переменной объясняет независимая переменная:

,

где

— сумма квадратов отклонений, объясняемых моделью линейной регрессии, которая характеризует рассеяние точек прямой регрессии относительно арифметического среднего,

— общая сумма квадратов отклонений, которая характеризует рассеяние зависимой переменной Y относительно арифметического среднего,

— сумма квадратов отклонений ошибки (не объясняемых моделью линейной регрессии), которая характеризует рассеяние зависимой переменной Y относительно прямой регресии.

Пример 3. Даны сумма квадратов отклонений, объясняемых моделью линейной регрессии (3500), общая сумма квадратов отклонений (5000) и сумма квадратов отклонений ошибки (1500). Найти коэффициент детерминации двумя способами.

Правильное решение и ответ.

F-статистика (статистика Фишера) для проверки качества модели линейной регрессии

Минимальное возможное значение F-статистики — 0. Чем выше значение статистики Фишера, тем качественнее модель линейной регрессии. Этот показатель представляет собой отношение объясненной суммы квадратов (в расчете на одну независимую переменную) к остаточной сумме квадратов (в расчете на одну степень свободы):

где m — число объясняющих переменных.

Сумма квадратов остатков

Сумма квадратов остатков (RSS) измеряет необъясненную часть дисперсии зависимой переменной:

где

—

остатки — разности между реальными значениями зависимой переменной и значениями, оценёнными уравнением линейной регрессии.

В случае качественной модели линейной регрессии сумма квадратов остатков стремится к нулю.

Стандартная ошибка регрессии

Стандартная ошибка регрессии (SEE) измеряет величину квадрата ошибки, приходящейся на одну степень свободы модели:

Чем меньше значение SEE, тем качественнее модель.

Пример 4. Рассчитать коэффициент детерминации для данных из примера 1.

Решение. На основании данных таблицы (она была приведена в примере урока о корреляционной зависимости) получаем, что SST = 63 770,593, SSE = 10 459,587, SSR = 53 311,007.

Можем убедиться, что выполняется закономерность SSR = SST — SSE:

63770,593-10459,587=53311,007.

Получаем коэффициент детерминации:

.

Таким образом, 83,6% изменений частного потребления можно объяснить моделью линейной регресии.

Итак, уравнение парной линейной регрессии:

.

В этом уравнении a — свободный член, b — коэффициент при независимой переменной.

Интерпретация свободного члена: a показывает, на сколько единиц график регрессии смещён вверх при x=0, то есть значение переменной y при нулевом значении переменной x.

Интерпретация коэффициента при независимой переменной: b показывает, на сколько единиц изменится значение зависимой переменной y при изменении x на одну единицу.

Пример 5. Зависимость частного потребления граждан от ВВП (истолкуем это просто: от дохода) описывается уравнением парной линейной регрессии . Сделать прогноз потребления при доходе в 20 000 у.е. Выяснить, на сколько увеливается потребление при увеличении дохода на 5000 у.е. Меняется ли потребление, если доход не меняется?

Решение. Подставляем в уравнение парной линейной регрессии xi = 20000 и получаем прогноз потребления при доходе в 20 000 у.е. yi = 17036,4662.

Подставляем в уравнение парной линейной регрессии xi = 5000 и получаем прогноз увеличения потребления при увеличении дохода на 5000 у.е. yi = 4161,9662.

Если доход не меняется, то xi = 0 и получаем, что потребление уменьшается на 129,5338 у.е.

Регрессионный анализ — раздел математической статистики, объединяющий практические методы исследования регрессионной зависимости между величинами по статистическим данным.

Наиболее частые задачи регрессионного анализа:

- установление факта наличия или отсутствия статистических зависимостей между переменными величинами;

- выявление причинных связей между переменными величинами;

- прогноз или восстановление неизвестных значений зависимых переменных по заданным значениям независимых переменных.

Также делаются проверки статистических гипотез о регрессии. Кроме того, при изучении связи между двумя величинами по результатам наблюдений в соответствии с теорией регрессии предполагается, что зависимая переменная имеет некоторое распределением вероятностей при фиксированном значении независимой переменной.

Одна из важнейших гипотез в регрессионном анализе — гипотеза о том, что коэффициент направления прямой регрессии генеральной совокупности равен нулю.

Если это предположение верно, то изменения независимой переменной X не влияют на изменения зависимой переменной Y: переменные X и Y не коррелированы, то есть линейной зависимости Y от X нет.

Нулевую гипотезу

рассматривают во взаимосвязи с альтернативной гипотезой

.

Статистика коэффициента направления

соответствует распределению Стьюдента с числом степеней свободы v = n — 2,

где — стандартная погрешность коэффициента направления прямой линейной регресии b1.

Доверительный интервал коэффициента направления прямой линейной регрессии:

.

Критическая область, в которой с вероятностью P = 1 — α отвергают нулевую гипотезу и принимают альтернативную гипотезу:

Пример 6. На основе данных из предыдущих примеров (о ВВП и частном потреблении) определить доверительный интервал коэффициента направления прямой линейной регресии 95% и проверить гипотезу о равенстве нулю коэффициента направления прямой парной линейной регрессии.

Можем рассчитать, что , а стандартная погрешность регрессии .

Таким образом, стандартная погрешность коэффициента направления прямой линейной регресии b1:

.

Так как и (находим по таблице в приложениях к учебникам по статистике), то доверительный интервал 95% коэффициента направления прямой парной линейной регрессии:

.

Так как гипотетическое значение коэффициента — нуль — не принадлежит доверительному интервалу, с вероятностью 95% можем отвергнуть основную гипотезу и принять альтернативную гипотезу, то есть считать, что зависимая переменная Y линейно зависит от независимой переменной X.

Всё по теме «Математическая статистика»

function-x.ru

пример, задачи, применение. Метод корреляционно-регрессионного анализа :: BusinessMan.ru

Корреляционно-регрессионный анализ – это один из самых распространенных методов изучения отношений между численными величинами. Его основная цель состоит в нахождении зависимости между двумя параметрами и ее степени с последующим выведением уравнения. Например, у нас есть студенты, которые сдали экзамен по математике и английскому языку. Мы можем использовать корреляцию для того, чтобы определить, влияет ли успешность сдачи одного теста на результаты по другому предмету. Что касается регрессионного анализа, то он помогает предсказать оценки по математике, исходя из баллов, набранных на экзамене по английскому языку, и наоборот.

Что такое корреляционная диаграмма?

Любой анализ начинается со сбора информации. Чем ее больше, тем точнее полученный в конечном итоге результат. В вышеприведенном примере у нас есть две дисциплины, по которым школьникам нужно сдать экзамен. Показатель успешности на них – это оценка. Корреляционно-регрессионный анализ показывает, влияет ли результат по одному предмету на баллы, набранные на втором экзамене. Для того чтобы ответить на этот вопрос, необходимо проанализировать оценки всех учеников на параллели. Но для начала нужно определиться с зависимой переменной. В данном случае это не так важно. Допустим, экзамен по математике проходил раньше. Баллы по нему – это независимая переменная (откладываются по оси абсцисс). Английский язык стоит в расписании позже. Поэтому оценки по нему – это зависимая переменная (откладываются по оси ординат). Чем больше полученный таким образом график похож на прямую линию, тем сильнее линейная корреляция между двумя избранными величинами. Это означает, что отличники в математике с большой долей вероятности получат пятерки на экзамене по английскому.

Допущения и упрощения

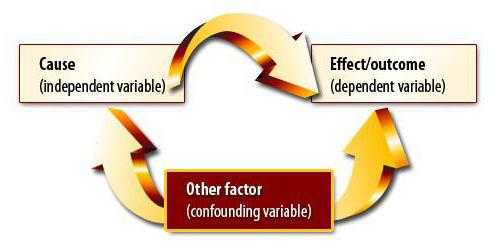

Метод корреляционно-регрессионного анализа предполагает нахождение причинно-следственной связи. Однако на первом этапе нужно понимать, что изменения обеих величин могут быть обусловлены какой-нибудь третьей, пока не учтенной исследователем. Также между переменными могут быть нелинейные отношения, поэтому получение коэффициента, равного нулю, это еще не конец эксперимента.

Линейная корреляция Пирсона

Данный коэффициент может использоваться при соблюдении двух условий. Первое – все значения переменных являются рациональными числами, второе – ожидается, что величины изменяются пропорционально. Данный коэффициент всегда находится в пределах между -1 и 1. Если он больше нуля, то имеет место быть прямо пропорциональная зависимость, меньше – обратно, равен – данные величины никак не влияют одна на другую. Умение вычислить данный показатель – это основы корреляционно-регрессионного анализа. Впервые данный коэффициент был разработан Карлом Пирсоном на основе идеи Френсиса Гальтона.

Свойства и предостережения

Коэффициент корреляции Пирсона является мощным инструментом, но его также нужно использовать с осторожностью. Существуют следующие предостережения в его применении:

- Коэффициент Пирсона показывает наличие или отсутствие линейной зависимости. Корреляционно-регрессионный анализ на этом не заканчивается, может оказаться, что переменные все-таки связаны между собой.

- Нужно быть осторожным в интерпретировании значения коэффициента. Можно найти корреляцию между размером ноги и уровнем IQ. Но это не означает, что один показатель определяет другой.

- Коэффициент Пирсона не говорит ничего о причинно-следственной связи между показателями.

Коэффициент ранговой корреляции Спирмана

Если изменение величины одного показателя приводит к увеличению или уменьшению значения другого, то это означает, что они являются связанными. Корреляционно-регрессионный анализ, пример которого будет приведен ниже, как раз и связан с такими параметрами. Ранговый коэффициент позволяет упростить расчеты.

Корреляционно-регрессионный анализ: пример

Предположим, происходит оценка эффективности деятельности десяти предприятий. У нас есть двое судей, которые выставляют им баллы. Корреляционно-регрессионный анализ предприятия в этом случае не может быть проведен на основе линейного коэффициента Пирсона. Нас не интересует взаимосвязь между оценками судей. Важны ранги предприятий по оценке судей.

Данный тип анализа имеет следующие преимущества:

- Непараметрическая форма отношений между исследуемыми величинами.

- Простота использования, поскольку ранги могут приписываться как в порядке возрастания значений, так и убывания.

Единственное требование данного типа анализа – это необходимость конвертации исходных данных.

Проблемы применения

В основе корреляционно-регрессионного анализа лежат следующие предположения:

- Наблюдения считаются независимыми (пятикратное выпадение «орла» никак не влияет на результат следующего подбрасывания монетки).

- В корреляционном анализе обе переменные рассматриваются как случайные. В регрессионном – только одна (зависимая).

- При проверке гипотезы должно соблюдаться нормальное распределение. Изменение зависимой переменной должно быть одинаковым для каждой величины на оси абсцисс.

- Корреляционная диаграмма – это только первая проверка гипотезы о взаимоотношениях между двумя рядами параметров, а не конечный результат анализа.

Зависимость и причинно-следственная связь

Предположим, мы вычислили коэффициент корреляции объема экспорта и ВВП. Он оказался равным единице по модулю. Провели ли мы корреляционно-регрессионный анализ до конца? Конечно же нет. Полученный результат вовсе не означает, что ВВП можно выразить через экспорт. Мы еще не доказали причинно-следственную связь между показателями. Корреляционно-регрессионный анализ – прогнозирование значений одной переменной на основе другой. Однако нужно понимать, что зачастую на параметр влияет множество факторов. Экспорт обуславливает ВВП, но не только он. Есть и другие факторы. Здесь имеет место быть и корреляция, и причинно-следственная связь, хотя и с поправкой на другие составляющие валового внутреннего продукта.

Гораздо опаснее другая ситуация. В Великобритании был проведен опрос, который показал, что дети, родители которых курили, чаще являются правонарушителями. Такой вывод сделан на основе сильной корреляции между показателя. Однако правилен ли он? Во-первых, зависимость могла быть обратной. Родители могли начать курить из-за стресса от того, что их дети постоянно попадают в переделки и нарушают закон. Во-вторых, оба параметра могут быть обусловлены третьим. Такие семьи принадлежат к низким социальным классам, для которых характерны обе проблемы. Поэтому на основе корреляции нельзя сделать вывод о наличии причинно-следственной связи.

Зачем использовать регрессионный анализ?

Корреляционная зависимость предполагает нахождение отношений между величинами. Причинно-следственная связь в этом случае остается за кадром. Задачи корреляционного и регрессионного анализа совпадают только в плане подтверждения наличия зависимости между значениями двух величин. Однако первоначально исследователь не обращает внимания на возможность причинно-следственной связи. В регрессионном анализе всегда есть две переменные, одна и которых является зависимой. Он проходит в несколько этапов:

- Выбор правильной модели с помощью метода наименьших квадратов.

- Выведение уравнения, описывающего влияние изменения независимой переменной на другую.

Например, если мы изучаем влияние возраста на рост человека, то регрессионный анализ может помочь предсказать изменения с течением лет.

Линейная и множественная регрессия

Предположим, что X и Y – это две связанные переменные. Регрессионный анализ позволяет предсказать величину одной из них на основе значений другой. Например, зрелость и возраст – это зависимые признаки. Зависимость между ними отражается с помощью линейной регрессии. Фактически можно выразить X через Y или наоборот. Но зачастую только одна из линий регрессии оказывается правильной. Успех анализа во многом зависит от правильности определения независимой переменной. Например, у нас есть два показателя: урожайность и объем выпавших осадков. Из житейского опыта становится ясно, что первое зависит от второго, а не наоборот.

Множественная регрессия позволяет рассчитать неизвестную величину на основе значений трех и более переменных. Например, урожайность риса на акр земли зависит от качества зерна, плодородности почвы, удобрений, температуры, количества осадков. Все эти параметры влияют на совокупный результат. Для упрощения модели используются следующие допущения:

- Зависимость между независимой и влияющими на нее характеристиками является линейной.

- Мультиколлинеарность исключена. Это означает, что зависимые переменные не связаны между собой.

- Гомоскедастичность и нормальность рядов чисел.

Применение корреляционно-регрессионного анализа

Существует три основных случая использования данного метода:

- Тестирование казуальных отношений между величинами. В этом случае исследователь определяет значения переменной и выясняет, влияют ли они на изменение зависимой переменной. Например, можно дать людям разные дозы алкоголя и измерить их артериальное давление. В этом случае исследователь точно знает, что первое является причиной второго, а не наоборот. Корреляционно-регрессионный анализ позволяет обнаружить прямо-пропорциональную линейную зависимость между данными двумя переменными и вывести формулу, ее описывающую. При этом сравниваться могут величины, выраженные в совершенно различных единицах измерения.

- Нахождение зависимости между двумя переменными без распространения на них причинно-следственной связи. В этом случае нет разницы, какую величину исследователь назовет зависимой. При этом в реальности может оказаться, что на их обе влияет третья переменная, поэтому они и изменяются пропорционально.

- Расчет значений одной величины на основе другой. Он осуществляется на основе уравнения, в которое подставляются известные числа.

Таким образом корреляционный анализ предполагает нахождение связи (не причинно-следственной) между переменными, а регрессионный – ее объяснение, зачастую с помощью математической функции.

businessman.ru

Регрессионный анализ — статистический метод исследования зависимости случайной величины от переменных :: BusinessMan.ru

В статистическом моделировании регрессионный анализ представляет собой исследования, применяемые с целью оценки взаимосвязи между переменными. Этот математический метод включает в себя множество других методов для моделирования и анализа нескольких переменных, когда основное внимание уделяется взаимосвязи между зависимой переменной и одной или несколькими независимыми. Говоря более конкретно, регрессионный анализ помогает понять, как меняется типичное значение зависимой переменной, если одна из независимых переменных изменяется, в то время как другие независимые переменные остаются фиксированными.

Во всех случаях целевая оценка является функцией независимых переменных и называется функцией регрессии. В регрессионном анализе также представляет интерес характеристика изменения зависимой переменной как функции регрессии, которая может быть описана с помощью распределения вероятностей.

Задачи регрессионного анализа

Данный статистический метод исследования широко используется для прогнозирования, где его использование имеет существенное преимущество, но иногда это может приводить к иллюзии или ложным отношениям, поэтому рекомендуется аккуратно его использовать в указанном вопросе, поскольку, например, корреляция не означает причинно-следственной связи.

Разработано большое число методов для проведения регрессионного анализа, такие как линейная и обычная регрессии по методу наименьших квадратов, которые являются параметрическими. Их суть в том, что функция регрессии определяется в терминах конечного числа неизвестных параметров, которые оцениваются из данных. Непараметрическая регрессия позволяет ее функции лежать в определенном наборе функций, которые могут быть бесконечномерными.

Как статистический метод исследования, регрессионный анализ на практике зависит от формы процесса генерации данных и от того, как он относится к регрессионному подходу. Так как истинная форма процесса данных, генерирующих, как правило, неизвестное число, регрессионный анализ данных часто зависит в некоторой степени от предположений об этом процессе. Эти предположения иногда проверяемы, если имеется достаточное количество доступных данных. Регрессионные модели часто бывают полезны даже тогда, когда предположения умеренно нарушены, хотя они не могут работать с максимальной эффективностью.

В более узком смысле регрессия может относиться конкретно к оценке непрерывных переменных отклика, в отличие от дискретных переменных отклика, используемых в классификации. Случай непрерывной выходной переменной также называют метрической регрессией, чтобы отличить его от связанных с этим проблем.

История

Самая ранняя форма регрессии — это всем известный метод наименьших квадратов. Он был опубликован Лежандром в 1805 году и Гауссом в 1809. Лежандр и Гаусс применили метод к задаче определения из астрономических наблюдений орбиты тел вокруг Солнца (в основном кометы, но позже и вновь открытые малые планеты). Гаусс опубликовал дальнейшее развитие теории наименьших квадратов в 1821 году, включая вариант теоремы Гаусса-Маркова.

Термин «регресс» придумал Фрэнсис Гальтон в XIX веке, чтобы описать биологическое явление. Суть была в том, что рост потомков от роста предков, как правило, регрессирует вниз к нормальному среднему. Для Гальтона регрессия имела только этот биологический смысл, но позже его работа была продолжена Удни Йолей и Карлом Пирсоном и выведена к более общему статистическому контексту. В работе Йоля и Пирсона совместное распределение переменных отклика и пояснительных считается гауссовым. Это предположение было отвергнуто Фишером в работах 1922 и 1925 годов. Фишер предположил, что условное распределение переменной отклика является гауссовым, но совместное распределение не должны быть таковым. В связи с этим предположение Фишера ближе к формулировке Гаусса 1821 года. До 1970 года иногда уходило до 24 часов, чтобы получить результат регрессионного анализа.

Методы регрессионного анализа продолжают оставаться областью активных исследований. В последние десятилетия новые методы были разработаны для надежной регрессии; регрессии с участием коррелирующих откликов; методы регрессии, вмещающие различные типы недостающих данных; непараметрической регрессии; байесовские методов регрессии; регрессии, в которых переменные прогнозирующих измеряются с ошибкой; регрессии с большей частью предикторов, чем наблюдений, а также причинно-следственных умозаключений с регрессией.

Регрессионные модели

Модели регрессионного анализа включают следующие переменные:

- Неизвестные параметры, обозначенные как бета, которые могут представлять собой скаляр или вектор.

- Независимые переменные, X.

- Зависимые переменные, Y.

В различных областях науки, где осуществляется применение регрессионного анализа, используются различные термины вместо зависимых и независимых переменных, но во всех случаях регрессионная модель относит Y к функции X и β.

Приближение обычно оформляется в виде E (Y | X) = F (X, β). Для проведения регрессионного анализа должен быть определен вид функции f. Реже она основана на знаниях о взаимосвязи между Y и X, которые не полагаются на данные. Если такое знание недоступно, то выбрана гибкая или удобная форма F.

Зависимая переменная Y

Предположим теперь, что вектор неизвестных параметров β имеет длину k. Для выполнения регрессионного анализа пользователь должен предоставить информацию о зависимой переменной Y:

- Если наблюдаются точки N данных вида (Y, X), где N < k, большинство классических подходов к регрессионному анализу не могут быть выполнены, так как система уравнений, определяющих модель регрессии в качестве недоопределенной, не имеет достаточного количества данных, чтобы восстановить β.

- Если наблюдаются ровно N = K, а функция F является линейной, то уравнение Y = F (X, β) можно решить точно, а не приблизительно. Это сводится к решению набора N-уравнений с N-неизвестными (элементы β), который имеет единственное решение до тех пор, пока X линейно независим. Если F является нелинейным, решение может не существовать, или может существовать много решений.

- Наиболее распространенной является ситуация, где наблюдается N > точки к данным. В этом случае имеется достаточно информации в данных, чтобы оценить уникальное значение для β, которое наилучшим образом соответствует данным, и модель регрессии, когда применение к данным можно рассматривать как переопределенную систему в β.

В последнем случае регрессионный анализ предоставляет инструменты для:

- Поиска решения для неизвестных параметров β, которые будут, например, минимизировать расстояние между измеренным и предсказанным значением Y.

- При определенных статистических предположениях, регрессионный анализ использует избыток информации для предоставления статистической информации о неизвестных параметрах β и предсказанные значения зависимой переменной Y.

Необходимое количество независимых измерений

Рассмотрим модель регрессии, которая имеет три неизвестных параметра: β0, β1 и β2. Предположим, что экспериментатор выполняет 10 измерений в одном и том же значении независимой переменной вектора X. В этом случае регрессионный анализ не дает уникальный набор значений. Лучшее, что можно сделать, оценить среднее значение и стандартное отклонение зависимой переменной Y. Аналогичным образом измеряя два различных значениях X, можно получить достаточно данных для регрессии с двумя неизвестными, но не для трех и более неизвестных.

Если измерения экспериментатора проводились при трех различных значениях независимой переменной вектора X, то регрессионный анализ обеспечит уникальный набор оценок для трех неизвестных параметров в β.

В случае общей линейной регрессии приведенное выше утверждение эквивалентно требованию, что матрица XТX обратима.

Статистические допущения

Когда число измерений N больше, чем число неизвестных параметров k и погрешности измерений εi, то, как правило, распространяется затем избыток информации, содержащейся в измерениях, и используется для статистических прогнозов относительно неизвестных параметров. Этот избыток информации называется степенью свободы регрессии.

Основополагающие допущения

Классические предположения для регрессионного анализа включают в себя:

- Выборка является представителем прогнозирования логического вывода.

- Ошибка является случайной величиной со средним значением нуля, который является условным на объясняющих переменных.

- Независимые переменные измеряются без ошибок.

- В качестве независимых переменных (предикторов) они линейно независимы, то есть не представляется возможным выразить любой предсказатель в виде линейной комбинации остальных.

- Ошибки являются некоррелированными, то есть ковариационная матрица ошибок диагоналей и каждый ненулевой элемент являются дисперсией ошибки.

- Дисперсия ошибки постоянна по наблюдениям (гомоскедастичности). Если нет, то можно использовать метод взвешенных наименьших квадратов или другие методы.

Эти достаточные условия для оценки наименьших квадратов обладают требуемыми свойствами, в частности эти предположения означают, что оценки параметров будут объективными, последовательными и эффективными, в особенности при их учете в классе линейных оценок. Важно отметить, что фактические данные редко удовлетворяют условиям. То есть метод используется, даже если предположения не верны. Вариация из предположений иногда может быть использована в качестве меры, показывающей, насколько эта модель является полезной. Многие из этих допущений могут быть смягчены в более продвинутых методах. Отчеты статистического анализа, как правило, включают в себя анализ тестов по данным выборки и методологии для полезности модели.

Кроме того, переменные в некоторых случаях ссылаются на значения, измеренные в точечных местах. Там могут быть пространственные тенденции и пространственные автокорреляции в переменных, нарушающие статистические предположения. Географическая взвешенная регрессия — единственный метод, который имеет дело с такими данными.

Линейный регрессионный анализ

В линейной регрессии особенностью является то, что зависимая переменная, которой является Yi, представляет собой линейную комбинацию параметров. Например, в простой линейной регрессии для моделирования n-точек используется одна независимая переменная, xi, и два параметра, β0 и β1.

При множественной линейной регрессии существует несколько независимых переменных или их функций.

При случайной выборке из популяции ее параметры позволяют получить образец модели линейной регрессии.

В данном аспекте популярнейшим является метод наименьших квадратов. С помощью него получают оценки параметров, которые минимизируют сумму квадратов остатков. Такого рода минимизация (что характерно именно линейной регрессии) этой функции приводит к набору нормальных уравнений и набору линейных уравнений с параметрами, которые решаются с получением оценок параметров.

При дальнейшем предположении, что ошибка популяции обычно распространяется, исследователь может использовать эти оценки стандартных ошибок для создания доверительных интервалов и проведения проверки гипотез о ее параметрах.

Нелинейный регрессионный анализ

Пример, когда функция не является линейной относительно параметров, указывает на то, что сумма квадратов должна быть сведена к минимуму с помощью итерационной процедуры. Это вносит много осложнений, которые определяют различия между линейными и нелинейными методами наименьших квадратов. Следовательно, и результаты регрессионного анализа при использовании нелинейного метода порой непредсказуемы.

Расчет мощности и объема выборки

Здесь, как правило, нет согласованных методов, касающихся числа наблюдений по сравнению с числом независимых переменных в модели. Первое правило было предложено Доброй и Хардином и выглядит как N = t^n, где N является размер выборки, n — число независимых переменных, а t есть числом наблюдений, необходимых для достижения желаемой точности, если модель имела только одну независимую переменную. Например, исследователь строит модель линейной регрессии с использованием набора данных, который содержит 1000 пациентов (N). Если исследователь решает, что необходимо пять наблюдений, чтобы точно определить прямую (м), то максимальное число независимых переменных, которые модель может поддерживать, равно 4.

Другие методы

Несмотря на то что параметры регрессионной модели, как правило, оцениваются с использованием метода наименьших квадратов, существуют и другие методы, которые используются гораздо реже. К примеру, это следующие методы:

- Байесовские методы (например, байесовский метод линейной регрессии).

- Процентная регрессия, использующаяся для ситуаций, когда снижение процентных ошибок считается более целесообразным.

- Наименьшие абсолютные отклонения, что является более устойчивым в присутствии выбросов, приводящих к квантильной регрессии.

- Непараметрическая регрессия, требующая большого количества наблюдений и вычислений.

- Расстояние метрики обучения, которая изучается в поисках значимого расстояния метрики в заданном входном пространстве.